Daten sind die Grundlage für erfolgreiche KI-Anwendungen. Doch es braucht noch mehr: Um die Potenziale von Künstlicher Intelligenz auszuschöpfen, ist ein umfassendes Datenmanagement erforderlich, das die vorliegenden Daten überhaupt erst zugänglich macht. Worauf es dabei ankommt, warum Data Science als Schlüsseldisziplin für Wissenschaft und Wirtschaft gilt und wie sich das Verständnis für Data Science-Prozesse fördern lässt, skizziert ein aktuelles Whitepaper der Plattform Lernende Systeme.

Künstliche Intelligenz (KI) versetzt uns teils in Erstaunen, teils nehmen wir sie in unserem Alltag als solche gar nicht zur Kenntnis. Fährt ein Auto autonom auf einer Teststrecke, besitzt dieses Bild noch eine gewisse Magie. Nutzen wir dagegen Übersetzungsdienste wie DeepL oder Google Translate, ist uns das selbstlernende System, das diese Dienste ermöglicht, kaum bewusst.

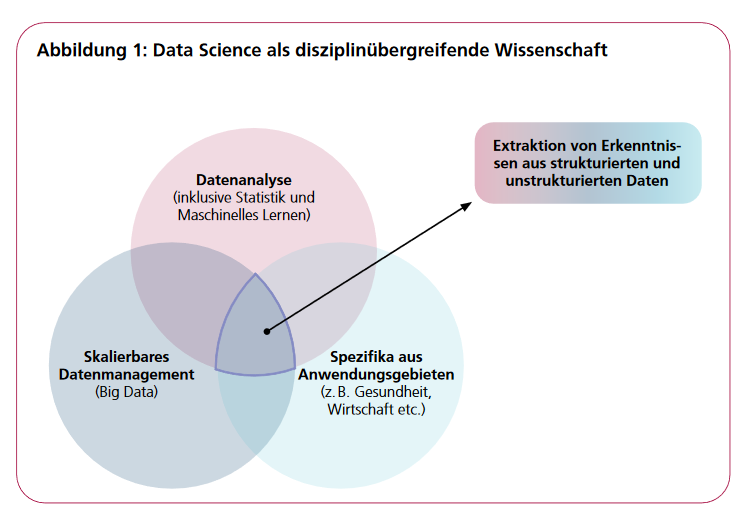

Die Entwicklung derartiger KI-Anwendungen basiert auf maschinellen Lernverfahren, die große Mengen an Daten nutzen. Daten allein reichen jedoch nicht, um das in ihnen verborgenen Potenzial auszuschöpfen. Sie müssen durch ein Datenmanagement zunächst einmal der Analyse zugeführt werden, das heißt: Sie müssen erfasst und in adäquater Weise aufbereitet werden. Eine simple Trennung von Datenmanagement einerseits und Datenanalyse sowie maschinellem Lernen anderseits greift jedoch zu kurz. Es ist vielmehr ein Zusammenspiel, das zu KI-Innovationen führt: Maschinelle Lernverfahren können das Datenmanagement unterstützen, dieses wiederum ist ein Fundament für KI-Systeme. Oft aber ist zudem Expertenwissen aus Anwendungsdomänen notwendig, um innovative Produkte und Dienstleistungen zu entwickeln. Diesem Zusammenspiel trägt die noch junge Disziplin der Data Science Rechnung.

Die Bedeutung von Expertise in Data Science wird schnell klar, wenn man sich vor Augen führt, dass das Erfassen und Aufbereiten der Daten bis zu 80 Prozent des Aufwands von KI-Projekten betragen kann (Yaddow, 2019). Weitere Herausforderungen bestehen darin, Daten effektiv und effizient zu verwalten und die Datenqualität zu wahren, da diese für die Korrektheit und Aussagekraft der Analyseergebnisse entscheidend ist (Rat für Informationsinfrastrukturen, 2019). Insgesamt ist es von erheblicher Bedeutung, Data Science-Prozesse in ihrer Gänze im Blick zu behalten, um die bestmögliche Qualität und Leistungsfähigkeit von KI-Systemen zu erreichen – aber auch, um die Grundlage für das Vertrauen in solche Systeme zu legen.

Data Science als iterativer Prozess

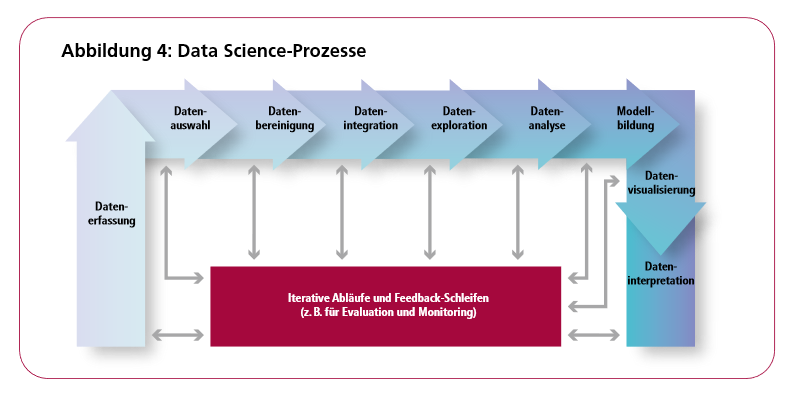

Die Basis vieler Data Science-Anwendungen sind Prozessketten, welche die Schritte der Datenerfassung, Auswahl, Bereinigung, Integration, Exploration, Analyse und Modellbildung bis hin zur Visualisierung und Interpretation umfassen. Diese Prozesse werden entweder explizit (prozedural oder deklarativ) spezifiziert und dann automatisiert ausgeführt oder eher implizit in interaktiver und explorativer Weise vollzogen. Häufig handelt es sich hierbei nicht um statische Abläufe, sondern um interaktive Prozesse, die menschliche Interventionen und Entscheidungen („Human-in-the-Loop“) erfordern. Teilweise bestehen diese aber auch aus iterativen Abläufen mit Feedback-Schleifen, um gegebenenfalls Daten, Methoden oder Parameter zu wechseln, neue Trainingsdaten zu beschaffen oder Modelle mit neuen Daten zu aktualisieren. Derartige Interventionen erfordern ein kontinuierliches Monitoring und eine Evaluation der Ergebnisse der einzelnen Schritte, etwa zur Qualität der Eingangsdaten oder der Modellgüte.

Im Zuge derartiger Prozesse kommen eine Vielzahl von Methoden aus unterschiedlichen Bereichen zum Einsatz. Beispiele hierfür sind Signalverarbeitungsmethoden, etwa zum Filtern der Daten, Verfahren zur Datenintegration, Statistik-Methoden für die Charakterisierung der Daten, die Ableitung von Kennzahlen oder Features, Zeitreihenanalyse etc., Datenvisualisierungsmethoden zur visuellen Datenexploration, Data-Mining- und Machine Learning-Methoden zum Bereinigen der Daten (z. B. Ersetzen fehlender Werte, Duplikaterkennung), sowie zur eigentlichen Modellbildung. Eine wichtige Rolle spielen in diesen Prozessen auch die Auswahl und Erfassung der Daten – beispielsweise als Trainingsdaten – sowie die Sicherstellung der Datenqualität. Neben Data Profiling und Data Cleaning kommt hierbei der Datenintegration und -anreicherung eine wichtige Rolle zu, um die oft heterogenen Ausgangsdaten erschließen und fusionieren zu können. In diesem Kontext kommen auch semantische Technologien wie Wissensgraphen zum Einsatz, deren Fakten unter anderem zur Validierung, Bewertung und Annotation von Daten genutzt werden. So liefern Datensammlungen und Wissensbasen wie Wikidata, Freebase, DBpedia oder YAGO umfangreiche Fakten beispielsweise für die Datenaufbereitung.

Speziell mit Methoden und Prozessen zur Erfassung, Verwaltung, Speicherung, Aufbereitung, Anreicherung und Bereitstellung der Daten beschäftigt sich das Gebiet Data Engineering. Im Mittelpunkt stehen dabei Fragen der Bereitstellung von performanten und zuverlässigen Infrastrukturen für das Datenmanagement, die fundamental für die effiziente Unterstützung von Data-Science-Prozessen sind, sowie Methoden für die Verwaltung und Aufbereitung der Daten und Modelle. Data Engineering wird daher im Folgenden als Oberbegriff für Datenmanagement, Datenintegration und Datenaufbereitung verwendet. Darüber hinaus ist eine visuelle Exploration und Analyse der Daten und Modelle unabdingbar (Visual Analytics), um die Qualität der Daten und Modelle zu beurteilen, mit den Daten und Modellen effektiv interagieren zu können oder neue Trainingsdaten abzuleiten.

Verständnis über die Prozesskette nötig

Um Data Science Anwendungen nachvollziehen, ihre Qualität beurteilen und somit ihre Vertrauenswürdigkeit attestieren zu können, ist allerdings nicht nur ein tiefes Verständnis der einzelnen Komponenten eines Data Science Prozesses notwendig, sondern auch ein Verständnis des Zusammenspiels der Komponenten und damit der Prozesskette als Ganzes.

Zu den zentralen Methoden und Techniken, die fundamental für Data Science sind – und damit auch die Künstliche Intelligenz – und weit über klassische relationale Datenbanksysteme hinausgehen, gehören:

- Datenverwaltung: Hierzu zählen Speichertechnologien und Datenstrukturen sowie Techniken zum physischen Design von Datenbanken wie Caching, Replikation, Indexierung, Datenkompression, Partitionierung für verteilte und parallele Datenhaltung sowie Vorberechnung und Materialisierung von häufig genutzten Daten. Dies betrifft auch die Verwaltung von Trainingsdaten und Modellen.

- Datenaufbereitung: Techniken zum Data Profiling und Data Cleaning mittels statistischer Verfahren und Methoden des maschinellen Lernens, Techniken der Datenintegration über die Kombination und Verknüpfung von Daten bis hin zu heterogenen Systemen.

- Performance und Skalierung: Datenmanagementsysteme sind für hochperformante und skalierbare Verarbeitung großer Datenmengen optimiert. Dies wird zum einen durch Verteilung und Parallelisierung der Verarbeitung erreicht. Neben verteilten bzw. parallelen Datenbanksystemen zählen hierzu auch Plattformen für die verteilte Verarbeitung in Cluster-Umgebungen wie Apache Spark oder der erfolgreichen deutschen Entwicklung Flink sowie Dateninfrastrukturen für das Cloud Computing. Hierbei besteht auch eine enge Verbindung zum verteilten Machine Learning. Zum anderen umfasst dies den effizienten Einsatz moderner Hardware (z.B. in Form von Main-Memory-Datenbanken, die Nutzung von GPU- oder FPGA-basierten Beschleunigern, sowie Multicore- und Cluster-Systemen) aber auch die Online-Verarbeitung von Datenströmen, wie sie zum Beispiel im Internet der Dinge, bei Industrie 4.0-Szenarien oder Social-Media-Plattformen anfallen. Zunehmend spielen auch spezielle Hardware-Architekturen wie Tensor-Recheneinheiten und neuromorphe Systeme eine wichtige Rolle.

- Optimierung und Ausführung komplexer Prozesse: Die Entwicklung und Ausführung komplexer Datenverarbeitungspipelines wird durch deklarative Anfrageverarbeitung inkl. Analytics-Methoden (z.B. Online Analytical Processing, OLAP) und Datenflussmodelle (wie in Spark oder Flink) unterstützt. Dies betrifft auch die Unterstützung kontinuierlichen Lernens, das heißt von iterativen Prozessen, in denen zusätzliche Trainingsdaten aus der Nutzung der KI-Anwendung berücksichtigt werden.

- Gewährleistung von Wiederholbarkeit und Nachvollziehbarkeit: Gerade für datengetriebene Lernprozesse ist es wichtig, die Modellbildung wiederhol- und nachvollziehbar zu gestalten, beispielsweise um fehlerhafte Vorhersagen, Änderungen der Trainingsdaten oder der Verarbeitungsprozesse nachvollziehen zu können. Hierfür bieten Datenmanagementtechniken wie Daten-Versionierung, Time-Travel-Anfragen oder Auditing Lösungswege an.

Maschinelles Lernen und Datenbanken werden heute zunehmend integriert gedacht und im Sinne von „Machine Learning Systems“ (Ratner 2019) als Teile eines Systems betrachtet. So werden Datenbanken nicht nur zur Speicherung der eigentlichen Daten, sondern auch zur Speicherung von berechneten Modellen und Programmcodes genutzt und dienen damit als Analysewerkzeug. Dies betrifft auch die Integration von Methoden des maschinellen Lernens – entweder, indem Lernverfahren in Datenbanksysteme integriert werden oder Datenmanagementtechniken (wie etwa Indexing) zur Beschleunigung von Machine Learning- und Analyseaufgaben genutzt werden. Deutlich wird dies an Entwicklungen wie der Software-Plattform für Big Data-Analysen Apache Spark, die inzwischen auch (wieder) eine Schnittstelle für die Datenbanksprache Structured Query Language (SQL) mit einem Anfrageoptimierer anbietet – also einer Anwendung, die nach dem effizientesten Weg sucht, um auf Daten zuzugreifen.

Verständnis für Data Science-Prozesse fördern

Es gibt verschiedene Ansätze, um Daten für die Gesellschaft künftig noch effizienter und effektiver nutzbar zu machen und das Verständnis von Data Science-Prozessen und Datenmanagementtechnologien in unserer Gesellschaft zu fördern. Dazu gehören unter anderem:

- Data Literacy: Wie bereits von der Gesellschaft für Informatik (GI) gefordert, muss Data Literacy-Kompetenzen ein breiterer Raum in Schule und Studium eingeräumt werden. Dies gilt weit über den Informatikunterricht in den Schulen oder Studiengänge mit Informatikbezug hinaus und betrifft neben Fähigkeiten zur Erschließung, Sammlung und Qualitätsbewertung von Daten auch grundlegende Kompetenzen zum Einsatz von Werkzeugen zur Datenverarbeitung und -analyse sowie zur Visualisierung und kritischen Interpretation der Ergebnisse.

- Data Science/Data Engineering-Ausbildung: In Studiengängen im Bereich Data Science aber auch in Informatikstudiengängen sollte mehr Wert auf Data-Engineering-Themen gelegt werden. Dies geht beispielsweise über die Inhalte klassischer Datenbank-Vorlesungen hinaus und betrifft neben Data Literacy-Kompetenzen etwa Aspekte von Datenintegration und -qualität, Datenexploration und -visualisierung aber auch alternative Datenmodelle und Verarbeitungsparadigmen. Für Studiengänge und Weiterbildungsangebote an Hochschulen im Bereich Data Science hat der Arbeitskreis „Data Science/Data Literacy“ unter Mitarbeit der Plattform Lernende Systeme Empfehlungen zur inhaltlichen Ausgestaltung erarbeitet (Gesellschaft für Informatik, 2019).

- Infrastruktur und Daten: Die eindrucksvollen Beispiele und Anwendungen der KI-Labore der Internet-Konzerne dürfen nicht zu einer unreflektierten Übernahme von erfolgreichen Modellen verführen. Neben dem Verständnis für die Lernmethoden und ihre Grenzen sowie der Kenntnis der genutzten Trainingsdaten erfordert dies aber auch, überhaupt die Möglichkeit zu haben, vergleichbare aufwendige Lernverfahren durchführen zu können. Hierfür werden geeignete Infrastrukturen mit ausreichender Speicher- bzw. Rechenkapazität und Datensammlungen (z.B. für Trainingsdaten) benötigt.

Gleichzeitig müssen auch „Small-Data“-Methoden berücksichtigt werden. Anwendungsbereiche, die gerade in Deutschland wichtige sind, wie etwa Medizintechnik oder Maschinenbau, zeichnen sich speziell im Umfeld von KMU durch deutlich kleinere Datenmengen aus, die oft nur schwach integriert sind. Infrastrukturen, Forschungs- und Ausbildungsprogramme für den KI-Bereich sollten dieser Situation Rechnung tragen.

Insgesamt spielen Datenmanagementtechnologien somit für Unternehmungen wie europäische Datenräume, die beispielsweise die Europäische Kommission in ihrer Datenstrategie vorantreiben möchte (Europäische Kommission, 2020), und Cloud-basierte Dateninfrastrukturen wie GAIA-X oder ganz allgemein Datenökosysteme eine zentrale Rolle. Da Recheninfrastrukturen auch Gegenstand der Forschung sind, ist auch ein Ausbau solcher Infrastrukturen notwendig, um zugrundeliegende Prozesse des Datenmanagements selbst gestalten und Experimente durchführen zu können. - Forschung: In künftigen Forschungsprogrammen, etwa der KI-Strategie der Bundesregierung oder in Forschungsprojekten von Unternehmen sowie Forschungs- und Entwicklungseinrichtungen, sollte der Bedeutung des Data Engineering als Gesamtprozess in Verbindung mit maschinellen Lernverfahren noch mehr Rechnung getragen werden. So können Stärken sowohl im Bereich der Erfassung und Auswahl der Daten, ihrer Exploration und Visualisierung als auch im Einsatz von KI- und Datenmanagement-Methoden in Data-Science-Prozessen weiter ausgebaut werden. In Anbetracht der wesentlichen Rolle von Datenmanagementtechnologien für die Datenräume und -ökosysteme der Zukunft ist eine noch stärkere Förderung einschlägiger Forschungsfelder zielführend.

- Anwendungsorientierung: Data Engineering spielt eine bedeutende Rolle, um Lernende Systeme in die Anwendungen zu bringen. Der Gesamtprozess aus Data Engineering und Lernenden Systemen sollte daher auch bei der Entwicklung und Umsetzung von KI-Anwendungen in Unternehmen noch mehr Berücksichtigung finden, indem besonderes Augenmerk auf die Erfassung, Vorverarbeitung und sichere Speicherung sowohl von Trainingsdaten als auch von Prozessdaten gelegt wird. Speziell in technischen bzw. industriellen Anwendungsfeldern wie Automatisierung und Predictive Analytics aber auch im Medizinbereich bilden qualitativ hochwertige Daten eine wesentliche Basis für die erfolgreiche Anwendung Lernender Systeme, gleichzeitig sind derartige Daten aber auch hochsensitiv. Infrastrukturen und Datenökosysteme müssen daher anwendungs- bzw. branchenspezifische Lösungen in geeigneter Weise berücksichtigen.

Quellen und Referenzen:

Daniel Keim, Kai-Uwe Sattler: Von Daten zu KI – Intelligentes Datenmanagement als Basis für Data Science und den Einsatz Lernender Systeme. Whitepaper aus der Plattform Lernende Systeme, München 2020

Europäische Kommission. (2020): Eine europäische Datenstrategie. https://ec.europa. eu/info/sites/info/files/communication-european-strategy-data-19feb2020_de.pdf (abgerufen am 25.09.2020).

Gesellschaft für Informatik (2018): Data Literacy und Data Science Education: Digitale Kompetenzen in der Hochschulausbildung. https://gi.de/themen/beitrag/data- literacy-und-data-science-education-digitale-kompetenzen-in-der-hochschulausbildung/ (abgerufen am 25.09.2020).

Rat für Informationsinfrastrukturen (2019): Herausforderung Datenqualität. http://www.rfii.de/?p=4043 (abgerufen am 25.09.2020).

Ratner, A. et al. (2019): MLSys: The New Frontier of Machine Learning Systems. https://arxiv.org/abs/1904.03257 (abgerufen am 25.09.2020).

Yaddow, W (2019): AI and BI Projects Are Bogged Down With Data Preparation Tasks. https://tdwi.org/Articles/2019/08/16/DIQ-ALL-AI-and-BI-Data-Preparation-Tasks.aspx (abgerufen am 25.09.2020).

Um einen Kommentar zu hinterlassen müssen sie Autor sein, oder mit Ihrem LinkedIn Account eingeloggt sein.