Mit Open Source das KI-Potenzial ausschöpfen

Der KI-Trend ist ungebrochen. Die Entwicklung, Bereitstellung und Verwaltung von KI-Modellen und -Anwendungen sind allerdings mit zahlreichen Herausforderungen verbunden. Um die KI-Einführung einfach und erfolgreich zu gestalten, sollten Unternehmen vier Faktoren im Blickfeld behalten: die KI-Infrastruktur, -Plattform und -Modelle sowie die KI-gestützten Applikationen.

Künstliche Intelligenz und Maschinelles Lernen werden zweifellos das Geschäftsleben und den Alltag in immer stärkerem Maße verändern. Unternehmen aller Branchen gehen zunehmend über kleinere Pilotprojekte hinaus und führen KI/ML-Funktionen in größerem Stil ein, um von Effizienzverbesserungen und Produktivitätssteigerungen zu profitieren.

Bei der Einführung von KI bestehen diverse Herausforderungen, wie beispielsweise die Operationalisierung von KI. Sie führen auch dazu, dass viele KI-Projekte vor einem Produktiveinsatz scheitern. Wie bei jedem anderen Softwareentwicklungsprojekt ist es deshalb von entscheidender Bedeutung, eine klare Struktur und exakte Ziele festzulegen. Analog zur App-Entwicklung ist zudem auch für die KI-Entwicklung ein Ansatz erforderlich, der auf DevOps-Prinzipien basiert, also ein MLOps-Prozess.

Klar ist auch, dass die Nutzung von KI die Komplexität eines Projekts in der Anwendungsentwicklung erhöht – es handelt sich dabei gewissermaßen um zwei verschiedene Workflows. Wenn aber sowohl die App- als auch die KI-Entwicklung auf der gleichen Plattform erfolgen, wird dieser Prozess erheblich vereinfacht.

Die konkrete Implementierung von KI variiert je nach Anwendungsfall, da KI umfangreiche und vielfältige Möglichkeiten für das gesamte Unternehmen bietet und nicht nur für eine einzelne Abteilung. Bei der Entscheidung, wie KI eingesetzt werden soll, stellen sich mehrere Fragen. Wird eine prädiktive oder generative KI benötigt? Soll eine eigene KI-Lösung entwickelt oder eine Fremdleistung bezogen werden. Wie kann ein Vendor-Lock-in vermieden werden? Darüber hinaus müssen auch die Verwaltung von Schatten-IT und wachsenden Workloads thematisiert werden. Und letztlich geht es auch um die Frage, ob ein Unternehmen der eingesetzten Lösung vertrauen kann, um KI auf verantwortungsvolle Weise zu nutzen. Dieser Fragenkomplex erfordert eine detaillierte Evaluierung der vier Bereiche Infrastruktur, Plattform, Modelle und Anwendungen.

Container-Plattform als KI-Infrastruktur

Bei der KI-Einführung sollte es in einem ersten Schritt um die Wahl der optimalen Infrastruktur für eine agile KI/ML-Umgebung gehen. Proprietäre Lösungen können es erschweren, KI/ML-Workloads in großem Umfang zu integrieren und zu bearbeiten. Open-Source-Container und Kubernetes-DevOps-Praktiken sind hier der Schlüssel zur Beschleunigung der KI- und ML-Lifecycles und zu einer intelligenten Anwendungsbereitstellung. Diese Technologien bieten Data Scientists die Agilität, Flexibilität, Portierbarkeit und Skalierbarkeit, die sie für Trainings, Tests und das Deployment von Modellen in der Produktion benötigen.

Überdies darf nicht vergessen werden, dass KI immer eine Teamaufgabe ist. Genau wie die richtigen Werkzeuge benötigt werden, müssen auch die richtigen Mitarbeitenden einbezogen werden. Das betrifft Data Engineers, Data Scientists, App-Entwickler und das IT-Ops-Team. Mit einer gemeinsamen Container-Plattform als Fundament kann im KI-Kontext dabei vermieden werden, dass eine Schatten-IT entsteht oder unterschiedliche Plattformen und Tools im Unternehmen zum Einsatz kommen.

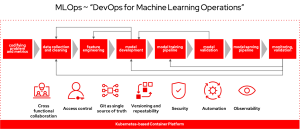

MLOps als KI-Plattform

Ein wichtiger Bestandteil einer KI-Umgebung ist immer auch die genutzte Plattform. Will ein Unternehmen einen Vendor-Lock-in ausschließen, mit neuen KI-Innovationen Schritt halten und alle möglichen Anwendungsfälle umsetzen, empfiehlt sich eine flexible, kompatible und hybride MLOps-Plattform, die auf Open Source basiert und eng mit einer Container-Plattform integriert ist.

Eine hybride MLOps-Plattform unterstützt das Training und Tuning sowie die Bereitstellung und Überwachung von KI-Modellen in der Cloud, am Edge und on-premises. Die Flexibilität und Kompatibilität werden durch einen modularen Aufbau und eine Plug-and-Play-Funktionalität mit Open-Source-Komponenten und anderen KI-Lösungen sichergestellt. Open Source ist dabei die Basis für eine hohe Transparenz und eine vertrauenswürdige KI sowie eine dynamische Produktentwicklung mit Innovationsführerschaft. Unternehmen können mit einem solchen Lösungsfundament die KI-Einführung sukzessive und einfach vorantreiben und somit auch die Kosten im Griff behalten.

Flexible Nutzung von KI-Modellen

Mit einer Container-und MLOps-Plattform als Basis besteht auch eine hohe Flexibilität im Hinblick auf die genutzten KI-Modelle. Zum einen wird sowohl die prädiktive oder klassische KI als auch die generative KI unterstützt. Zum anderen können Unternehmen eigene Basismodelle von Grund auf neu erstellen oder auch Open-Source-Modelle wie Llama 2 nutzen. Bei der Nutzung eines Model-as-a-Service-Angebots ist der Datenschutz zu beachten. Vertrauliche Daten können nicht mit Dritten wie den Model-as-a-Service-Anbietern geteilt werden.

KI-gestützte Applikationen als Ziel

Bei jeder KI-Nutzung darf nicht außer Acht gelassen werden, dass es letztlich immer um die KI-gestützten Anwendungen selbst geht. KI-Modelle müssen für eine konkrete Aufgabe nutzbar sein. Ein gutes Beispiel dafür sind Code-Assistenten, die die Effizienz und Produktivität von Entwicklern erheblich steigern. Auch hier gilt, dass die KI-Entwicklung und die App-Entwicklung auf derselben Container-Plattform stattfinden, sodass sichere KI-fähige Anwendungen erstellt werden können, die unternehmensweit skalierbar sind. Unternehmen müssen bei jedem KI-Projekt somit immer das Ziel im Auge haben, KI-fähige Anwendungen zu konzipieren. Nur hier wird sich der Return on Investment ihrer KI-Initiativen zeigen.

Zweifellos wird in diesem Jahr die strategische Integration von Hybrid-Cloud-Lösungen in KI-Initiativen zu einem entscheidenden Trend werden. Unternehmen werden erkennen, dass es unerlässlich ist, sowohl lokale als auch Cloud-Ressourcen zu nutzen, um den maximalen Nutzen aus ihren KI-Aktivitäten zu ziehen. Dieser Trend wird durch die Notwendigkeit forciert, Datensicherheit und -hoheit mit der für anspruchsvolle KI-Modelle erforderlichen Rechenleistung in Einklang zu bringen. Unternehmen werden dabei vor allem Plattformen nutzen, die die Integration allgemein verfügbarer und privater Daten erleichtern und die Hybrid Cloud als Eckpfeiler für den KI-Erfolg und die Innovation betrachten. Darüber hinaus werden sich Open-Source-Software und umfangreiche Partner-Ökosysteme als die wesentlichen Treiber für die schnelle und einfache Entwicklung von KI/ML-Lösungen herauskristallisieren.

(MLOps.png) Der MLOps-Workflow im Überblick. (Quelle: Red Hat)

Um einen Kommentar zu hinterlassen müssen sie Autor sein, oder mit Ihrem LinkedIn Account eingeloggt sein.