Unsere Mobilität muss und wird sich ändern, unsere Städte gelangen mit dem zunehmenden Individualverkehr an ihre Grenzen, und die ehrgeizigen Ziele im Bereich Klimaschutz lassen sich nur mit innovativen, nachhaltigen Konzepten erreichen. Gerade hat die Bundesregierung ein milliardenschweres Förderprogramm auf den Weg gebracht, das u.a. für die Mobilität der Zukunft positive Impulse geben soll. Städte wie München arbeiten aktiv daran, sich zu einer Smart City zu entwickeln. Ein zentraler Bestandteil aller Mobilitätskonzepte ist das Autonome Fahren. Während das für viele Menschen wie Zukunftsmusik klingt, beschäftigen sich Unternehmen weltweit mit konkreten Fragen: Welche Infrastruktur ist erforderlich, um die große Menge der Daten zu speichern und zu übertragen? Wie sollen Fahrerassistenzsysteme Entscheidungen treffen? Eines ist sicher, ohne hochwertige Daten und deren ebenso schnelle wie zuverlässige Auswertung sind autonom fahrende Fahrzeuge nicht zu betreiben. Doch warum beginnt Autonomes Fahren im Rechenzentrum? Ein innovatives Projekt im NTT Technology Experience Lab zeigt die Zusammenhänge und verdeutlicht, warum eine sichere „Experimentier-Plattform“ beim Erwerb neuer Kompetenzen entscheidend ist.

Kerntechnologie Künstliche Intelligenz

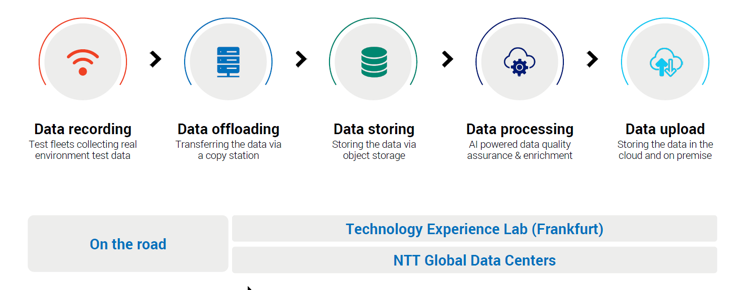

Die Kerntechnologie zur Entwicklung selbstfahrender Fahrzeuge ist Künstliche Intelligenz (KI). Basierend auf den Daten, die unzählige Sensoren ermitteln, treffen Fahrerassistenzsysteme alle Entscheidungen, die der Fahrer oder die Fahrerin bislang selbst getroffen haben. Doch bevor diese Systeme auf der Straße tatsächlich genutzt werden können, müssen sie trainiert werden. Was sich zunächst einfach anhört, gestaltet sich in Realität sehr aufwendig. Zunächst gilt es die Trainingsdaten im Fahrzeug zu gewinnen, sie zu speichern und sie anschließend auszuwerten. Ein gemeinsames Projekt von Global Data Centers EMEA mit externen Partnern bildet den gesamten Prozess der Datensammlung im Fahrzeug, der Datenübertragung zum Rechenzentrum und in die Cloud sowie der Vorbereitung, Verarbeitung und Speicherung der Trainingsdaten ab und setzt diesen unter realen Bedingungen um.

Testlauf in sicherer Umgebung

Ein Rechenzentrum muss vor allem eines sein – sicher. Und das gleich in mehrfacher Hinsicht. Daten müssen vor unerlaubtem Zugriff durch Zugangskontrollen und IT-Sicherheitssysteme sowie vor äußeren Einwirkungen (Strom- und Notstromversorgung, redundante Kälte- und Klimasysteme, umfassende Brandbekämpfungs- und Brandschutzsysteme) geschützt werden. Sogenannte Colocation Rechenzentren bieten eben diese sichere Infrastruktur, innerhalb derer sie abgeschlossene Flächen oder 19“ Racks vermieten. Die Kunden mieten sich auf den Flächen ein und können in der geschützten Umgebung ihre eigene Rechenzentrums-Infrastruktur aufbauen und betreiben. Allerdings: Testläufe für neue Technologien und Produkte führen die Unternehmen auf ihren Produktiv-IT-Systemen mit allen unternehmenskritischen Anwendungen in der Regel nur ungern durch.

Um dennoch bei Testszenarien die gleichen Sicherheitsstandards anzulegen, betreibt NTT mehrere Technology Experience Labs unter anderem an den Standorten Frankfurt und München. Mehr als 140 Partner bieten Technologien und Anwendungen in dieser einfach und schnell nutzbaren Umgebung an. Vorgefertigte Anwendungsfälle ermöglichen es zu experimentieren, ohne langfristige Verpflichtungen einzugehen oder eine Produktivumgebung zu gefährden. Das Technology Experience Lab bietet eine sichere Infrastruktur, um innovative Technologien und Prozesse zu testen und zu validieren und leistet damit einen wesentlichen Beitrag zum Erwerb neuer Kompetenzen und zur digitalen Transformation. Die Komplexität der Abläufe zeigt das „Data Garage“ Projekt, das für die Entwicklung autonom fahrender Fahrzeuge als wegweisend gilt. Aktuell beteiligen sich an diesem Projekt fünf Partner, die unterschiedliche Aufgaben übernehmen:

○ b-plus: Datensammlung während des Fahrens

○ IBM: Datenspeicherung on premise

○ Incenda AI: Intelligente Datenverarbeitung

○ Lenovo: Hardware für die Datenspeicherung und Künstliche Intelligenz

○ NTT Global Data Centers: Datenübertragung und Hochladen der Daten in die Cloud

Ziel der Zusammenarbeit ist es, eine Infrastruktur zu entwickeln und aufzubauen, um Daten, die für das Training von Fahrerassistenzsystemen in autonom fahrenden Fahrzeugen benötigt werden, sicher zu verarbeiten.

Datenspeicherung beim Fahren

Um automatisierte Fahrfunktionen zu entwickeln, testen und validieren, müssen in realen Fahrsituationen Daten gesammelt werden. Die in den Fahrzeugen verwendeten Sensoren zur Erfassung des Umfelds wie Kameras, Radar- und LiDAR-Systeme, entwickeln sich aktuell rasant weiter und ihre Auflösung, wie auch die Zahl der verbauten Komponenten selbst, steigt stetig. Daraus resultiert ein sehr hohes Datenaufkommen von bis zu 6 GByte/s, das ausgekoppelt, verarbeitet und gespeichert werden muss. Im hier betrachteten Anwendungsprojekt werden im ersten Schritt die Sensorrohdaten an einen Datenspeicher übertragen, der sich im Testfahrzeug befindet. Die Anforderungen an einen solchen Datenspeicher sind hoch: Er muss kompakt und unempfindlich sein in Hinblick auf Temperaturschwankungen sowie Vibrationen und Erschütterungen im Betrieb. Darüber hinaus muss im Fahrzeugbordnetz mit einer schwankenden und limitierten Stromversorgung gerechnet werden, die durch ein intelligentes Energiemanagement ausgeglichen werden muss. Angesichts der weiteren Analyse und Verarbeitung der Daten gilt es, diese schon bei der Speicherung auf ihre Qualität prüfen. Entscheidend sind dabei die Integrität und zeitliche Korrelation der Daten.

So werden beispielsweise alle im Messaufbau vorhandenen Uhren synchronisiert und exakte Zeitstempel auf die einzelnen Datenpakete gesetzt. Sie gewährleisten die korrekte Zuordnung der jeweiligen Daten beim Zusammenfügen zu einem Umgebungsmodell.

Intelligentes und Effizientes Recording

Bei Datenströmen von 6 Gbyte/s summieren sich schnell Terabytes an Daten, die ins Rechenzentrum eingespeist werden müssen. Bis vor wenigen Jahren glaubte man noch, es sei notwendig, alle Daten zu sammeln. Längst weiß man, dass es entscheidender ist, selektierte Daten zu speichern und diese mit den relevanten Zusatzinformationen wie der exakten Sensorkonfiguration, Firmwareständen von Steuergeräten oder messtechnischen Konfigurationen anzureichern. Bereits während der Fahrt müssen die Daten geprüft und mit zusätzlichen Informationen im Rahmen des Pre-Labeling gekennzeichnet werden. Bei Bedarf lassen sich dann schon im Fahrzeug die relevanten Szenen filtern, die aktuell zum Training der Fahrerassistenzsysteme benötigt werden. Dazu sind in den Fahrzeugen fahrzeugtaugliche Hochleistungsrechner mit mehreren leistungsfähigen Server-Prozessoren und Grafikkarten für eine parallele Bildverarbeitung integriert. Schon im Fahrzeug wird künstliche Intelligenz genutzt, um in einem Vorauswahlprozess zu entscheiden, wann eine Szene im Datenspeicher aufgezeichnet werden soll.

Daten ins Rechenzentrum einspeisen

Um die Messdaten weiterverarbeiten zu können, müssen die täglich anfallenden Gigabyte an Daten aus dem Fahrzeug sicher und schnell ins Rechenzentrum übertragen werden. Dazu gibt es zwei wesentliche Konzepte, die von der Verfügbarkeit einer schnellen Verbindung zum Rechenzentrum am Fahrzeugstandort abhängen.

- Wechselbare Speichermedien

Sollte keine schnelle Verbindung verfügbar sein, können wechselbare Speichermedien, wie Cartridges aus dem Fahrzeug entnommen, versendet und dem Verantwortlichen im Rechenzentrum übergeben werden.

- Bei einer ausreichenden Verbindung – im Idealfall bis zu 128 Gbit/s – können die Messdaten direkt aus dem Fahrzeug kopiert werden.

Im aktuellen Projekt werden die Testdaten auf Cartridges gespeichert. Diese wechselbaren Speichermedien werden nach einer abgeschlossenen Testfahrt ins Rechenzentrum gebracht. Dort übernimmt ein zertifizierter Service-Mitarbeiter die Medien und überträgt sämtliche Daten über eine Kopierstation auf die Speichersysteme vor Ort. Diese befinden sich während des Testbetriebs im Rahmen des Projektesbei einer dedizierten Nutzung durch ein Unternehmen in der Regel im eigenen Colocation-Bereich des Anwenders. Sind die Daten im Rechenzentrum angelangt, erfolgt die weitere Aufbereitung.

Intelligente Datenverarbeitung

Nützliche und repräsentative Daten aus den bei einer Testfahrt gesammelten Informationen zu extrahieren, erfordert einen hohen Aufwand. Die Daten der unterschiedlichen Sensoren müssen begutachtet und mit vorhandenen Datensätzen abgeglichen werden. Eine umfassende Aufgabe, die meist Experten aus den Fachbereichen übernehmen. Effizienter und schneller lassen sich die Aufgaben erledigen, wenn Data Scientists und KI-Ingenieure den Prozess begleiten. Die aufgezeichneten Datenpunkte werden in einer Vorab-Verarbeitung direkt nach der Aufzeichnung von KI-Algorithmen geprüft und nach bestimmten Meta-Informationen selektiert. Aufgrund unterschiedlicher Anwendungsfälle lassen sich die Daten dann entsprechend filtern:

- Datentagging

Die aufgezeichneten Daten werden analysiert und ein definierter Datensatz an Metainformationen wird erstellt und hinzugefügt. Beispiele dazu sind Kennzeichnungen (Tags) wie Wetterbedingungen, die Fahrumgebung, Kreuzungssituationen oder das Auftauchen anderer Verkehrsteilnehmer.

- Grenzfälle entdecken

Bei großen Datenmengen erfordert es einen enormen Aufwand, um Spezialfälle zu entdecken, die während einer Fahrt aufgetaucht sind. Doch genau diese Grenzfälle, wie das Auftauchen von Rollstuhlfahrern, Rikschas oder Tieren, werden für das gezielte Training der Fahrerassistenz-Systeme unter Umständen gerade benötigt.

- Clevere Datenauswahl

Während einer Testfahrt innerhalb einer Stadt oder selbst bei Testfahrten in mehreren Städten der gleichen Region tauchen häufig Gemeinsamkeiten mit bestehenden, für Trainingszwecke markierten Daten auf. Es stellen sich demzufolge zwei Fragen:

- Welche Daten innerhalb der Aufzeichnung sind von besonderem Interesse?

- Welche Daten innerhalb der Aufzeichnung sind in Hinblick auf die schon gekennzeichneten Daten nützlicher?

Diese Methode berechnet den Grad der Gleichheit für jeden Datenpunkt, so dass wertvolle Datenpunkte gekennzeichnet werden können. Dieser Algorithmus erfordert es, zunächst den existierenden Datensatz als Input zu analysieren.

Die im Rahmen des hier vorgestellten Projektes verwendeten Algorithmen basieren auf künstlichen neuronalen Netzen. Diese lehnen sich an den Aufbau unseres Gehirns an. In einem abstrahierten Modell werden die Anwendungsprobleme in miteinander verbundenen Neuronen abgebildet und computerbasiert gelöst. Die Performance des Algorithmus‘ hängt dabei direkt ab von der Qualität des zum Training genutzten Datensatzes. Formale und logische Fehler müssen im Rahmen einer klar strukturierten Qualitätsprüfung gefunden und bereinigt werden. Um diese Aufgaben schnell und zuverlässig ausführen zu können, sind hohe Rechenleistungen mit den entsprechenden Grafikprozessoren erforderlich.

Hardware zur Datenspeicherung und KI

Der Fokus bei der Auswertung der Trainingsdaten liegt sicher auf Software und Algorithmen, bei der Hardware geht man stillschweigend davon aus, dass sie funktioniert. Doch die Daten müssen auf entsprechenden Datenspeichern sicher verwahrt und die Algorithmen für KI auf den entsprechenden Prozessoren berechnet werden. Eine wichtige Rolle im vorliegenden Projekt spielt dabei die Nutzung der Cloud. In einer Cloud arbeiten zahlreiche Serversysteme für den Anwender unbemerkt zusammen. Der Nutzer kann somit zum einen flexibel auf die Daten zugreifen, zum anderen ist hier die benötigte Rechenkapazität nach Bedarf schnell verfügbar. Im Gegensatz zu den – meist mit dem Begriff Cloud assoziierten – öffentlichen Cloud-Plattformen basieren private Clouds technisch auf dem gleichen Ansatz der verteilten Systeme, befinden sich jedoch in Kundenhand. Im vorliegenden Projekt werden die Daten vom externen Datenträger über eine Kopierstation auf einen privaten Cloudspeicher im Rechenzentrum übertragen. Der Vorteil dabei ist, dass die Datenaufnahme innerhalb des Colocation-Rechenzentrums mit hoher Bandbreite stattfindet, ohne Bandbreite in anderen Netzen zu benötigen. Sobald die Daten im privaten Cloudspeicher angekommen sind, werden sie – wie schon beschrieben – in Hochleistungs-Servern weiterverarbeitet. Wichtig ist dabei die direkte Netzwerkverbindung der Serversysteme zum privaten Cloudspeicher. Die Server müssen vom Speichersystem mit einem konstant hohen Datenstrom versorgt werden, um eine effiziente Datenverarbeitung zu gewährleisten.

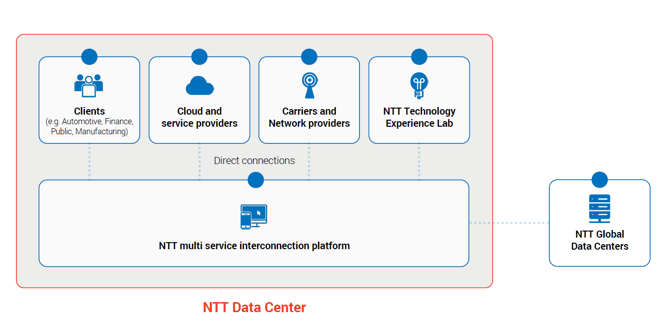

Zugang zu globalen Cloud-Plattformen

Am Ende sollen mit den gesammelten Trainingsdaten Fahrerassistenzsysteme entwickelt und optimiert werden. Dazu müssen sie den Herstellern der Systeme zugänglich sein. Colocation-Rechenzentren sind meist über ein eigenes leistungsfähiges Netzwerk miteinander verbunden und bieten über eine eigene Plattform direkte Zugänge zu verschiedenen Carriern, Cloud Service Providern und Internetknoten. Über virtuelle Ports erhalten die Kunden Zugriff auf diese Plattform und können ihre sensiblen Daten schnell und sicher zwischen ihren eigenen Systemen und der Cloud übertragen. Im hier beschriebenen Anwendungsfall lassen sich die gesammelten und intelligent aufbereiteten Daten nach Bedarf entweder in die private Cloud-Infrastruktur eines Kunden oder in öffentliche Cloud-Infrastrukturen hochladen.

Fazit

Autonomes Fahren ist ein vielschichtiger Prozess, der bei der Sammlung und Aufbereitung der Trainingsdaten startet. Die passende Hard- und Software zur Verarbeitung der Daten spielt dabei eine ebenso große Rolle wie die Umgebung, in der die Daten übertragen und verarbeitet werden. Hochleistungs-Serversysteme und Speichersysteme für Massendaten benötigen eine sichere Stromversorgung, eine effiziente Kühlung und müssen vor unerlaubten Zugriffen geschützt werden. Gleichzeitig ist es nachvollziehbar, dass Unternehmen erste Test-Infrastrukturen nicht in ihrem Produktiv-Rechenzentrum beherbergen möchten. Das Technology Experience Lab verbindet beide Welten und unterstützt – wie der vorliegende Anwendungsfall zeigt – die Entwicklung innovativer und digitaler Prozesse in Unternehmen.

Um einen Kommentar zu hinterlassen müssen sie Autor sein, oder mit Ihrem LinkedIn Account eingeloggt sein.