Trends 2025: Künstliche Intelligenz und Graphtechnologie

Graphdatenbanken spielen schon seit Jahren eine Schlüsselrolle in der Analyse hochkomplexer Netzwerke und Daten. Im Zusammenspiel mit Künstlicher Intelligenz (KI) sind sie für Datenverarbeitung, Mustererkennung und Wissensmodellierung fast nicht wegzudenken. Ein Blick auf die Trends und Synergien beider Technologien.

Künstliche Intelligenz in Form von Generativer KI (GenAI) hat in den letzten Jahren eine rasante Verbreitung in Unternehmen erfahren, sei es in der Automatisierung von Prozessen, der Kundeninteraktion oder der Datenanalyse. Eine Umfrage von Bitkom ergab, dass sich 57% der Unternehmen in Deutschland mit dem Thema KI beschäftigen. 20% nutzen bereits entsprechende Systeme, während 37% den Einsatz noch planen. Ende 2024 wollen laut Analystenhaus Deloitte 67 % der befragten Führungskräfte weltweit die Investitionen in GenAI in ihrem Unternehmen erhöhen.

Trotz des rasanten Wachstums gibt es signifikante Herausforderungen. Viele Unternehmen stehen vor Schwierigkeiten bei der Integration der intelligenten Lösungen in bestehende IT-Infrastrukturen. Zudem fehlt es häufig an Fachkräften mit den erforderlichen Kenntnissen, um KI-Projekte erfolgreich umzusetzen. Datenschutz und ethische Fragestellungen stellen weitere Hürden dar, die gelöst werden müssen, um das volle Potenzial der Technologie auszuschöpfen.

Neue KI-Technologien am Start

Ein Blick auf den Gartner Hype Cycle zeigt, dass GenAI sich langsam aber sicher aus der Hype-Phase verabschiedet und in die produktive Phase übergeht. Doch während sich viele Unternehmen bereits in der aktiven Implementierung und Evaluierung konkreter Anwendungsfälle befinden, stehen bereits neue KI-Technologien vor der Tür.

- Agentic AI

Nach den Chatbots kommen die KI-Agenten. Damit sind KI-Systeme gemeint, die komplette Workflows und Routineaufgaben selbständig und proaktiv übernehmen. Dazu erhalten sie Zugriff auf verschiedene Werkzeuge wie Datenbanken, Schnittstellen und Service-Integrationen und steuern diese entsprechend an. Agentic AI-Systeme verfügen über sogenannte „Chaining“-Fähigkeiten: Aufgaben werden zunächst in einzelne Schritte zerlegt, um sie dann iterativ sowie dynamisch abzuarbeiten. Neue Eingaben bzw. Befehle nach jedem Schritt sind nicht mehr nötig. Vielmehr passen die Agenten ihre Aktionen dem Kontext an und delegieren Teilaufgaben an andere Tools – darunter auch an andere KI-Systeme.

Agentic AI-Systeme zielen auf den Einsatz von autonomen Systemen ab, zum Beispiel in der Robotik, aber auch in Business-Anwendungen. Die KI-Agenten in Anthropics KI-Modell Claude können Computer fast wie ein Mensch bedienen – sie tippen, klicken und recherchieren eigenständig im Internet. Auch Microsoft entwickelt Agenten, die in Zukunft Aufgaben in Bereichen wie Vertrieb, Kundensupport und Buchhaltung übernehmen. Auch Open AI hat einen KI-Agenten auf den Markt gebracht, der selbstständig Aufgaben erledigt.

- Reasoning AI

Eine weitere spannende Entwicklung ist Reasoning AI. Im Gegensatz zu bisherigen Ansätzen, die auf Mustererkennung basieren, ist die KI darauf ausgerichtet, komplexe logische Schlüsse zu ziehen und Ursache-Wirkungs-Beziehungen besser zu verstehen. Im Unterschied zu GenAI setzen Reasoning-Modelle auf ein „lautes Nachdenken“, bei dem sie mögliche Lösungswege durchspielen, bevor sie einen Vorschlag präsentieren. Dieser Prozess, der als „Chain of Thought“ bekannt ist, erhöht zwar die Antwortzeit, führt jedoch zu qualitativ hochwertigeren Ergebnissen.

OpenAIs Modell o1 schaffte es dank dieser Fähigkeiten in der US-Mathematik-Olympiade (AIME) unter die Top 500. Als vielversprechende Anwendungsgebiete gelten zudem die medizinische Diagnostik sowie die Analyse juristischer Fragen.

KI-Evaluation dringend gefragt

Bevor diese neuen KI-Technologien den Markt erobern, sind noch einige wichtige Fragen zu klären. KI-Agenten zum Beispiel müssen sich effektiv kontrollieren und im Notfall stoppen lassen. Den Chatbot für Textvorschläge oder Standard-Anschreiben zu nutzen, ist eine Sache. Die komplette Korrespondenz mit Geschäftspartner oder Kunden komplett einem KI-System zu überlassen, eine ganz andere.

Und auch der „Denkprozess“ der Reasoning AI mag spannend sein. Er verläuft aber für Außenstehende unsichtbar, im Inneren des KI-Modells ab (Black Box). Das erschwert die Nachvollziehbarkeit und verhindert Transparenz und Kontrolle. Zudem sind die langen Verarbeitungszeiten und höheren Kosten in der Forschung durchaus vertretbar, nicht aber für Echtzeitaufgaben oder einfache Abfragen durch Anwender.

Die Validierung und Evaluation von KI gehören überhaupt zu den wichtigsten Themen der nächsten Jahre. Kontroll- und Feedbackmechanismen sind dringend nötig, um Fehlerfortpflanzung zu vermeiden, die Datenqualität zu prüfen und regulatorische Richtlinien zu erfüllen. Herkömmliche Ansätze greifen hier noch oft zu kurz.

Um die KI zu kontrollieren, kommt wieder KI zum Einsatz. Large Language Models (LLMs) können zum Beispiel die Ergebnisse einer anderen LLM hinterfragen und auf die Korrektheit bzw. Angemessenheit der Frage sowie auf unangemessene oder illegale Inhalte untersuchen. KI-basierte Fairness-Toolkits testen auf Data Bias. Zudem scheint es möglich, in den Modellen enthaltene Strukturen (sogenannte Interpretable Features) zu steuern und diese als Sicherheitsmechanismen einzusetzen.

GraphRAG: Fusion von Knowledge Graphen und KI

Die Fortschritte, die KI allein in den letzten zwei Jahren zurückgelegt hat, sind beachtlich und stimmen zuversichtlich. Bei GenAI zum Beispiel stießen die LLMs bei der Beantwortung spezifischer Fragen anfangs noch an Grenzen. Die Ergebnisse ließen sich kaum zurückverfolgen oder erklären. Und da die Sprachmodelle auf statischen Trainingsdaten basieren, waren die Antworte oft nicht aktuell.

Tatsächlich wurde schnell klar: Wie leistungsstark ein KI-System im Unternehmensumfeld ist, hängt stark von der Fähigkeit der Verantwortlichen ab, die Modelle mit ihren eigenen Datensätzen zu verknüpfen und anzureichern. Graphtechnologie im Zusammenhang mit Retrieval Augmented Generation (GraphRAG) etablierte sich hier sehr schnell als wichtiger Grundbaustein für zuverlässige KI-Anwendungen.

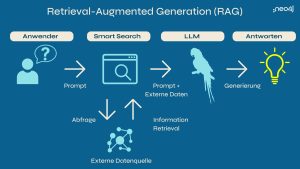

Bei RAG werden im Rahmen des LLM-Abfrageprozesses ergänzende Informationen aus externen Datenspeichern abgerufen und für die Generierung von Antworten genutzt. Externe Quellen können zum Beispiel Unternehmensdatenbanken, Dokumente oder Websites sein, die domänenspezifische, proprietäre Daten enthalten. Der RAG-Prozess verarbeitet die natürlichsprachliche Frage eines Nutzers, ergänzt sie um externe Informationen und übergibt beides gebündelt an das LLM.

RAG-Prozess mit einem Knowledge Graphen als externe Quelle (Quelle: Neo4j)

GraphRAG nutzt einen Knowledge Graphen (KG) als eine solche zusätzliche Quelle. Hierbei wird Wissen strukturiert dargestelltwobei Entitäten (wie Personen, Orte oder Konzepte) als Knoten und ihre Beziehungen als Kanten dargestellt werden. KGs organisieren und verknüpfen die Informationen, um semantische Zusammenhänge zu verstehen und abzubilden. Oder anders gesagt: Sie liefern den nötigen Kontext, um die Daten tatsächlich „verstehen“ zu können. Das macht die GenAI-Ergebnisse genauer, für spezifische Anwendungsfälle relevanter und auf Grund der neuen Daten aktueller. Auch das Risiko von KI-Halluzinationen sinkt deutlich.

KI in der Unternehmenspraxis: Klein, vertikal und modular

Für Unternehmen besteht der aktuelle Fokus vor allem darin, bestehende KI-Technologien effizient in ihre Geschäftsprozesse zu integrieren. Diese Integration betrifft nicht nur Compliance und Fachwissen, sondern auch die Kostenfrage. Wenn KI in größerem Maßstab eingesetzt wird, sind die Ausgaben nicht unerheblich. Zudem bieten auf öffentlich zugänglichen Daten trainierte LLMs wenig Potenzial, sich vom Wettbewerb zu differenzieren. Aus diesem Grund richten Unternehmen ihr Augenmerk zunehmend auf spezialisierte KIs, die gezielt auf spezifische Anwendungsfälle und Anforderungen abgestimmt sind und fortlaufend verfeinert, optimiert und angepasst werden (Post-Training).

Statt LLMs setzen immer mehr Unternehmen auf Small Language Models (SLMs), die in spezialisierten Domänen und Branchen durchaus mit den größeren Modellen mithalten können. Ihr Vorteil liegt darin, dass sie sich leichter kontrollieren und validieren lassen (z. B. durch Knowledge Graphen). Das Training mit hochwertigen Daten erfolgt zudem schneller. Und schließlich verbrauchen sie im Vergleich zu LLMs nur etwa 5% des Energieverbrauchs – ein nicht unerheblicher Aspekt angesichts wachsender Nachhaltigkeitsanforderungen. Darüber hinaus lassen sich mit leistungsstarken LLMs qualitativ hochwertige synthetische Trainingsdaten für SLMs erzeugen, um diese effektiv „anzulernen“.

Unternehmen stehen vor der Herausforderung, KI-Technologien effektiv in bestehende Systeme und Lösungen zu integrieren. Dies erfordert, dass KI in die oft komplexen und gewachsenen IT-Infrastrukturen eingebunden wird. Auf operativer Ebene ist daher ein grundlegendes Framework erforderlich, das klare Richtlinien, standardisierte Prozesse und festgelegte Ziele umfasst. Es gilt, alle relevanten KI-Stakeholder im Unternehmen (z. B. C-Level, Entwicklerteams, IT, Compliance und Fachabteilungen) abzuholen.

Auf technischer Ebene muss KI in modularen, integrierbaren Komponenten bereitgestellt werden, die an strategisch wichtigen Stellen (z. B. bei der Nutzerinteraktion oder Datenanalyse) eingebunden werden können. Die Verwaltung dieser zunehmend komplexeren und wachsender Architekturen wird in den kommenden Jahren eine der zentralen Herausforderungen sein.

Gelingt es Unternehmen, die KI sinnvoll zu integrieren und sie innerhalb von bestehenden, spezifischen Anforderungen zu nutzen, ist das Innovationspotential enorm. Wer dann noch in Basistechnologien, rund um das Datenmanagement, investiert, darunter zum Beispiel Graphdatenbanken, der ist auch für zukünftige KI-Innovation gut gewappnet.

Um einen Kommentar zu hinterlassen müssen sie Autor sein, oder mit Ihrem LinkedIn Account eingeloggt sein.