Anwendungen mit Künstlicher Intelligenz (KI) eröffnen neue Möglichkeiten und werden unser aller Leben verändern. Eine stetig steigende Anzahl von Apps, Sensoren und Geräten generieren eine Flut an Daten und damit die Grundlage für neue KI-Systeme. Es gibt viel Gutes, das mit Hilfe von KI-Systemen geschaffen werden kann – ob in der Medizintechnik, im Umweltschutz oder in der Logistik – aber wir sind uns ebenso bewusst, dass KI-Anwendungen auch missbraucht beziehungsweise angepeilte Ziele verfehlt werden können.

Gleichzeitig gewinnt der internationale Wettbewerb bei der Entwicklung und Anwendung von KI-Systemen an Fahrt und man fragt sich zu Recht, welche der mannigfachen Möglichkeiten von KI-Systemen wie mit dem europäischen Wertekanon vereinbart werden können. Aktuell zeigen die Diskussionen um ChatGPT welche Fragestellungen noch zu beantworten sind. Was darf eine KI und was nicht? Und wie kann die Einhaltung der Vorgaben kontrolliert werden? Woher wissen Nutzende, ob die Inhalte/Ergebnisse/Vorschläge von einer KI kommen oder nicht und auf welcher Basis?

Vertrauen in KI: Unternehmen & Gesellschaft fordern mehr Überprüfung

Die Diskussionen zeigen, dass klare und nachvollziehbare Aussagen zur funktionalen sowie ethischen Qualität von KI-Systemen ein gesellschaftliches Bedürfnis sind. Das belegen auch Studien des TÜV-Verbandes – wie die Unternehmer-Studie 2020[1] oder die Verbraucher-Studie aus 2021[2]. Regulierung soll die Grenzen setzen, in denen sich KI bewegen darf. Dabei muss der Spagat gelingen, Innovationen nicht abzuwürgen, wettbewerbsfähig zu bleiben, aber Risiken ausreichend zu minimieren.

Standards und Normen sollen hier die Detailtiefe liefern, wie regulatorische Vorgaben umgesetzt werden können. Durch die rasante Entwicklung von KI hinken allerdings Regulierung und Standardisierung dem Stand der Technik hinterher. Anwendungen wie ChatGPT zeigen deutlich, dass noch ein großer Klärungsbedarf vorliegt. Ebenso wird gefordert, dass die Balance zwischen Stringenz und Aufwand bei möglichen Prüfungen gewahrt bleiben – Regulierung darf keine Innovationsbremse sein, sondern muss Werte schaffen.

Regulierung als Wettbewerbsvorteil

Um dies sicherzustellen, dass Regulierung Innovationen und Entwicklung fördert, braucht es ein kohärentes und eindeutiges Regelwerk aus Gesetzen und Normen. Viele zucken bei dem Stichwort Regulierung erstmal zusammen. Dabei bringt eine maßvolle und praktisch umsetzbare Regulierung viele Vorteile mit sich:

· Mit einer Auszeichnung „KI-Qualität Made in Germany / in der EU“ können sich Unternehmen mit ihren KI-Anwendungen von Marktbegleitern aus anderen Ländern differenzieren.

· Regulierung schafft Transparenz und Vertrauen, damit ermöglicht sie eine schnellere Marktdurchdringung und auch Umsatzwachstum.

· Eine schlüssige Regulierung schafft Leitplanken für die Entwicklung von KI-Systemen und kann als Katalysator für hohe Qualität dienen.

· Unternehmen erhalten einen stabilen und sicheren Rechtsrahmen zum Wirtschaften.

International ist hier auch ein Wettlauf entstanden: Wer zuerst reguliert übernimmt fast zwangsläufig die Führung und gestaltet weltweit das KI-Geschehen. Die EU hat sich hier frühzeitig mit Anforderungen – auch an ethische Aspekte der KI – platziert.

Überblick Regulierung und Standardisierung

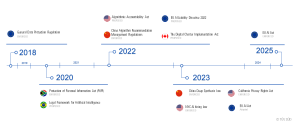

Die Regulierung und Standardisierung von KI-Anwendungen entwickeln sich weltweit gerade dynamisch. Diese nicht im Blick zu haben kann sich als fahrlässig erweisen und zu deutlichen Verzögerungen beim Markteintritt führen. So sind bereits in den vergangenen Jahren einige Gesetze in Kraft getreten, die bei den relevanten KI-Anwendungen berücksichtigt werden müssen.

[Grafik 1: Weltweit relevante Gesetze für KI-Anwendungen © TÜV SÜD]

China hat eine Vorreiterrolle eingenommen und setzt seit März 2022 eine neue Richtlinie bezüglich von KI generierten Handlungsempfehlungen[3] um, und seit Dezember 2022 eine Richtlinie bezüglich KI generierten Inhalten[4]. Aus den USA ist auf nationaler Ebene vor allem die „AI Bill of Rights“[5] zu nennen, die aber bislang keine konkreten Regeln zur Zulässigkeit von KI enthält. Diesbezüglich gibt es aber auf der Ebene der Bundestaaten nennenswerte Initiativen, wie zum Beispiel dem Gesetz aus New York City zur Regelung des Einsatzes von KI zur Auswahl von Bewerbern bei der Einstellung (Automated employment decision tools 2021[6])

Das ambitionierteste Gesetzesvorhaben ist der EU AI Act[7], der voraussichtlich im Jahr 2025 in Kraft treten wird. Beim EU AI Act werden übergreifend vor allem die Grundrechte von natürlichen Personen und sensiblen Rechtsgütern (Art. 3.5 KI-VO-E) geschützt. Dabei erfolgt eine risikobasierte Unterteilung. Neben unannehmbaren Risiken und damit verbotenen Anwendungen, wie sogenanntes „Social scoring“ (Art. 5.2.2. KI-VO-E), erfolgt die Einteilung von KI-Anwendungen in 4 Risikoklassen. Unter Hochrisiko-KI-Systeme fallen bspw. alle Produkte, die sich aktuell schon einem Konformitätsbewertungsverfahren unterziehen müssen. Darunter fallen bspw. Medizinprodukte der höchsten Risikoklasse. Diese Hochrisiko-KI-Systeme werden rechtliche Anforderungen in Bezug auf Daten, Daten-Governance, Dokumentation und das Führen von Aufzeichnungen, Transparenz und Bereitstellung von Informationen für die Nutzer, menschliche Aufsicht, Robustheit, Genauigkeit und Sicherheit erfüllen müssen.

[Grafik 2: Risikoklassen des EU AI Acts © TÜV SÜD]

In der Standardisierung nimmt ISO/IEC JTC 1/SC 42 Artificial Intelligence eine zentrale Rolle ein. Im Arbeitsprogram (siehe Webseite[8]) sind sowohl fundamentale Standards zur Begrifflichkeit von KI, als auch Dokumente zur Datenqualität, Aspekten der Vertrauenswürdigkeit von KI, Applikationen von KI und den technischen Details von KI zu finden. Derzeit befinden sich 27 Dokumente in der aktiven Bearbeitung, die teilweise kurz vor der Veröffentlichung stehen. Weitere 17 wurden bereits abgeschlossen, darunter unter anderem: ISO/IEC 22989:2022 Artificial intelligence concepts and terminology, ISO/IEC 23053:2022 Framework for Artificial Intelligence (AI) Systems Using Machine Learning (ML), Serie ISO/IEC TR 20547 „Information Technology — Big data reference architecture“, ISO/IEC TR 24028:2022 Overview of trustworthiness of artificial intelligence, and ISO/IEC TR 24027:2021 Bias in AI systems and AI aided decision making.

Bezüglich der Konformität sind vor allem zertifizierbare Standards relevant, die derzeit dahingehend überprüft werden, inwieweit sie die Anforderungen der Regulierung erfüllen, um offiziell (zum Beispiel als harmonisierter Standard in der EU) anerkannt zu werden. Von Interesse sind zum Beispiel ISO/IEC 42001 Artificial Intelligence – Management System, die Serie ISO/IEC 5259-x Data quality for analytics and ML, und die ISO/IEC 23894 Risk Management.

Neben ISO/IEC ist vollem auch IEEE SA zu nennen, die mit der IEEE 7000-Serie[9] einen vielversprechenden Vorschlag eingebracht hat, der die ethischen Aspekte abdeckt. IEEE CertifAIEdTM[10] ist ein objektiv zertifizierbares Rahmenwerk hinsichtlich ethischer Aspekte von KI-Anwendungen. Die IEEE-Standards wurden von der EU analysiert und es gibt die Empfehlung der entsprechenden Forschungsgruppe, bestimmte Aspekte daraus in das EU AI Act einzubinden[11].

Allein diese wenigen Beispiele zeigen die Herausforderung: Es ist per se schon anspruchsvoll qualitativ hochwertige KI-Anwendungen zu erstellen. Für Organisationen ist es darüber hinaus äußerst herausfordernd, die komplexen und sich dynamisch entwickelnden Regulierungs- und Standardisierungsansätze im Blick zu behalten und in den Entwicklungsprozess einzubinden.

Marktfähigkeit und Rechtssicherheit optimieren

Eine systematische und entwicklungsbegleitende Herangehensweise an die Qualitätssicherung von KI-Anwendungen kann Entwicklern/Organisationen in vielfacher Weise helfen. So können dadurch Risiken besser erkannt und optimal damit umgegangen werden. Fehler werden vermieden und regulatorische Anforderungen im Blick behalten. In Summe kann das zu einem beschleunigten Entwicklungsprozess führen. Gleichzeitig wird so eine höhere Qualität der KI-Performance ermöglicht. Besonders hervorzuheben ist, dass durch eine frühzeitige und systematische Auseinandersetzung mit dem Thema eine höhere Rechtssicherheit einhergeht und die KI-Anwendung somit überhaupt marktfähig ist.

Gerade das Thema Haftung ist viel diskutiert. Grundsätzlich gelten vorhandene rechtliche Vorgaben auch für KI-Anwendungen. Die Gesetze und Rechtsprechung sind unabhängig von der Technologie, mit der Produkte oder Anwendungen betrieben werden. Das heißt, dass bestehende Gesetze und Rechtsprechung wie Produkt- und Produzentenhaftung, Produktsicherheitsrecht usw. auch weiterhin gelten. Neu ist hingegen, dass KI neue Risken mit sich bringt, die gesondert behandelt werden müssen. Das heißt, je nach Produktart und Einsatz sind Hersteller und/oder Betreiber rechtlich für das Produkt verantwortlich und können bei Fehlfunktionen haftbar gemacht werden.

Ein Produkt (mit KI) muss nachweisbar nach Stand der Technik entwickelt und ordnungsgemäß betrieben und gewartet werden, um vor Schadensersatzforderungen geschützt zu sein. Umso wichtiger ist ein systematischer Ansatz analog geltender und anwendbarer Normen, weil diese in der Rechtsprechung als „Stand der Technik“ anerkannt sind und somit Haftungsrisiken mindern können. Gleichzeitig gilt es, die Gesetzesentwicklung im Blick zu behalten, um auf Veränderungen frühzeitig reagieren zu können. So läuft aktuell im EU-Parlament ein Verfahren, um Haftungslücken bei KI-Anwendungen in einen europaweiten Rechtsrahmen zu schließen.

Wie kann KI-Qualität verbessert werden?

Organisationen bewegen sich bezüglich von KI-Qualität vielfach auf neuem Terrain: Der gesamte Lebenszyklus eines KI-Systems muss mit entsprechenden Prozessen im Qualitätsmanagement-System abgebildet werden. Die KI-Risiken müssen bewertet, Qualitätsziele müssen definiert, und Qualitätssicherungs-Prozesse müssen in jeder Phase implementiert und dokumentiert werden.

Die Orientierung an Standards kann hier helfen. Dabei kann der Bogen geschlagen werden bis hin zu den Grundlagen des Qualitätsmanagements. Der Begriff Qualität wird hier als der Grad definiert, zu dem die Merkmale eines Systems den Anforderungen entsprechen. Das Grundprinzip des Qualitätsmanagements ist Vorbeugung, Qualitätskosten sind die Kosten für Nichterfüllung der Qualitätsanforderungen und das Null-Fehler-Prinzip sollte das Idealziel sein[12].

Komplexe KI erfordert eine strategische Herangehensweise

Qualität von KI hat mehr Dimensionen als die von Hard- und Software. Zur klassischen Performanz (bspw. erkennt das KI-System Anomalien & Muster schnell und zuverlässig), kommen Kriterien wie Robustheit, Datenschutz, aber auch Transparenz, Erklärbarkeit und Berücksichtigung ethischer Werte. Aber wie leitet man die konkreten Qualitätsanforderungen an ein KI-System ab? Wie kann die Qualität bei einem sich selbst entwickelnden System sichergestellt werden? Hier wurde von TÜV SÜD ein erstes Qualitätsmanagementsystem entwickelt, das die Anforderungen aus Regularien und Standards zusammenfasst und daher grundsätzlich für jede Art von KI-Anwendung adaptiert werden kann.

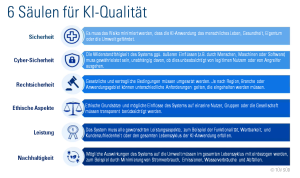

[Grafik 3: 6 Säulen für KI-Qualität © TÜV SÜD]

Es werden 6 zu betrachtende Säulen unterschieden, die die Qualität einer KI-Anwendung beeinflussen und die bereits ab der Ideenfindung und entwicklungsbegleitend entsprechend begleitet werden sollten (siehe Grafik 3). Jede dieser Säulen beinhaltet relevante Qualitätskriterien, die dann unter dem Aspekt der Säule bewertet werden. Insgesamt werden so über 100 Qualitätskriterien wie Interpretierbarkeit, Resilienz, und Robustheit betrachtet.

Die einzelnen Aspekte der Qualität von KI-Anwendungen lassen sich in vielen Parametern, messen, quantifizieren und einordnen. Eine Neuheit bezüglich der technischen Konformitätsprüfungen sind ethische Aspekte. KI-Anwendungen entscheiden selbstständig und greifen somit in die Lebensrealitäten vieler Menschen ein, weiter als die meisten bisherigen Anwendungen/Software-Produkte. Oftmals muss auch eine Balance zwischen verschiedenen ethischen Aspekten gefunden werden, die sich entgegenstehen. Ein Beispiel hierzu sind Anwendungen aus dem Gesundheitswesen. Auf der einen Seite ist es erstrebenswert, durch KI möglichst genaue und auf die Person angepasste Diagnostik zu liefern, wofür aber auf der anderen Seite sensible Daten von verletzlichen Personengruppen gesammelt werden müssen. Hier muss eine detaillierte Abwägung und ein Konsens gefunden und auch fixiert und somit überprüfbar und eventuell sogar auditierbar werden. Speziell zum Thema Ethik ist dies ein schwieriges Unterfangen.

Um auch hier die Qualitätsanforderungen nachvollziehbar zu machen, ist es wichtig, auch die Qualitätskriterien transparent und messbar zu gestalten. Nur so ist auch eine Überprüfung oder gar ein Audit möglich. Die standardgebende Organisation des Weltverbands der Ingenieure und Techniker, IEEE SA (Institute of Electrical and Electronics Engineers Standards Association) hat hier eine erste, weltweit anwendbare Standard-Reihe (7000er Reihe) zu ethischen Aspekten bei KI-Anwendungen herausgegeben. Mit IEEE CertifAIEdTM gibt es auch ein Zertifizierungsprogram, um die erreichten ethischen Kriterien zu überprüfen und zu dokumentieren. Eine Auswahl der Dokumente aus der IEEE 7000 Serie werden inzwischen vom IEEE SA kostenlos zur Verfügung gestellt und ermöglichen so auch weniger finanzstarken Organisationen den Zugang zu einer praxisnahen Handreichung zur Erstellung hochwertiger und menschenzentrierte KI-Anwendungen. TÜV SÜD kooperiert mit IEEE SA und setzt IEEE’s CertfiAIEdTM für ethische Aspekte innerhalb des Qualitätsmanagementsystems ein.

Anfangen Step-by-step

Der Einstieg in ein systematisches Qualitätsmanagement bei KI-Anwendungen beginnt mit der Sensibilisierung und dem Training der Mitarbeitenden an einem KI-Projekt. Nur mit einem entsprechend sensibilisierten und ausgebildeten Team können die vielschichtigen Herausforderungen analysiert und geeignete Aktivitäten geplant werden. Konkrete Maßnahmen sollten dann auch genau bei den oben genannten Qualitätskriterien anfangen. Die relevanten Qualitäts- und Anwendungsanforderungen müssen möglichst frühzeitig definiert werden. Je konkreter und messbarer, umso besser.

Im zweiten Schritt werden anhand einer Risikobewertung alle relevanten Qualitätskriterien selektiert. Das Ergebnis ist ein Risikoprofil für alle 6 Qualitätssäulen. Anschließend wird das Risikoprofil auf die technischen, organisatorischen und prozessualen Aspekte abgebildet bzw. diesbezüglich bewertet, die für ein Unternehmen im Hinblick auf einen bestimmten KI-Anwendungsfall relevant sind. Eine Priorisierung hilft Unternehmen, die gewonnenen Erkenntnisse in einen Maßnahmenkatalog zu überführen. Ein Beispiel könnte sein, dass die Sicherheit und Ethik eines Unternehmens als Hauptrisiko identifiziert wurden. Als Ergebnis der Abbildung bzw. Bewertung könnten dann bei organisatorischen Aspekten der Weiterbildungsbedarf von Mitarbeitern, bei prozessualen Aspekten die Betrachtung des Datenlebenszyklus und bei technischen Aspekten das Training der KI als Priorität erkannt werden. Das Unternehmen ist nun in der Lage, konkrete Maßnahmen umzusetzen und ein entsprechendes Qualitätsmanagementsystem aufzubauen.

[1] https://www.tuev-verband.de/pressemitteilungen/ki-studie

[2] https://www.tuev-verband.de/studien/ki-studie-2021

[3] http://www.cac.gov.cn/2022-01/04/c_1642894606258238.htm

[4] http://www.gov.cn/zhengce/zhengceku/2022-12/12/content_5731431.htm

[5] https://www.whitehouse.gov/ostp/ai-bill-of-rights/

[6] https://legistar.council.nyc.gov/LegislationDetail.aspx?ID=4344524&GUID=B051915D-A9AC-451E-81F8-6596032FA3F9&Options=Advanced&Search

[7] https://eur-lex.europa.eu/legal-content/DE/TXT/?uri=CELEX%3A52021PC0206

[8] https://www.iso.org/committee/6794475/x/catalogue/p/0/u/1/w/0/d/0

[9] https://ieeexplore.ieee.org/browse/standards/get-program/page/series?id=93

[10] https://engagestandards.ieee.org/ieeecertifaied.html

[11] https://op.europa.eu/en/publication-detail/-/publication/3bddb039-909e-11ed-b508-01aa75ed71a1/language-en

[12] DIN EN ISO 9000:2015-11, aktuell gültige Qualitätsmanagement-Norm

Um einen Kommentar zu hinterlassen müssen sie Autor sein, oder mit Ihrem LinkedIn Account eingeloggt sein.