Digital Empathy fokussiert sich auf emotional angepasste und optimierte Mensch-Computer-Interaktionen. Stimmungen und Emotionen der Nutzer sollen verstanden und die Interaktion darauf angepasst werden. Zur Erfassung dieser Nutzeremotionen etablieren sich automatisierte und echtzeitbasierte Affective-Computing-Methoden. Eye Tracking ist als klassische Methodik im Bereich der Usability-Forschung verbreitet und identifiziert visuelle Auslöser, die die Aufmerksamkeit und Reaktionen der Nutzer beeinflussen. Eine kombinierte Methodik aus Affective Computing und Eye Tracking kann die Wechselwirkung von Aufmerksamkeit und Emotion erfassen und so verbesserte Digital Empathy etablieren.

1. Empathie in der digitalen Welt

Die digitale Transformation führt zu einem zunehmenden Innovationsdruck bei der Entwicklung digitaler Produkte und Dienstleistungen. Führende Unternehmen wie Google, Amazon oder Facebook haben hohe Standards im Bereich der User Experience [UX] gesetzt und intuitive Interaktionen für Konsumenten zur Norm werden lassen. Die digitale Welt konzentriert sich immer mehr auf User-Experience-Optimierung, insbesondere auf die Steigerung von Conversion Rates. Dabei geht es im Wesentlichen um drei Fragen:

- “Was machen die Nutzer mit dem (digitalen) Produkt?”

- “Wie verwenden die Nutzer das (digitale) Produkt bzw. wie kaufen sie es?” und

- “Warum bewerten die Nutzer das Produkt positiv, mögen es, lieben es – oder warum nicht?”

Während Log-File-Analysen die ersten beiden Fragen schnell und valide beantworten können, liegt die Antwort auf das Warum oft in subjektiv empfundener Aufmerksamkeit und Emotion der Nutzer. Dieses Warum unterscheidet letztlich die reine Usability (d.h. die funktionale Produktbewertung) von der User Experience (d.h. der ganzheitlichen emotionalen Produktbewertung).

In der digitalen Emotionsforschung zielt Affective Computing auf die automatisierte, echtzeitbasierte Messung und Erkennung von Emotionen der Nutzer durch Sensoren und Maschinelles Lernen ab, um angepasste Reaktionen in der Mensch-Computer-Interaktion zu ermöglichen (Picard 1997). Affective Computing versucht damit, das Warum zu ergründen. Laut dem Gartner-Hype-Cycle befindet sich diese Digital- und Marktforschung mit dem Schwerpunkt auf Empathie derzeit in der frühen “Innovationsauslöser”-Phase. Mit Affective Computing sind sowohl immense Chancen (z.B. empathisch gestaltete digitale User-Experience-Forschung als neues Geschäftsfeld) als auch potenziell disruptive Innovationen (z.B. ähnlich wie Google Analytics als skalierte Selbstbedienungstechnologie) für die Marktforschung verbunden.

In der Aufmerksamkeitsforschung können Eye-Tracking-Systeme die genauen visuellen Auslöser identifizieren, die emotionale Reaktionen der Nutzer hervorrufen. Die Kombination aus Affective Computing und Eye Tracking kann also die (digitale) Empathie-Forschung auf eine neue Ebene heben.

2. User Emotionen mit Affective Computing erfassen

Derzeit erheben UX-Forscher Daten zu Aufmerksamkeit, Emotionen, Einstellungen und Motiven hauptsächlich über (UX-)Nutzerinterviews und standardisierte oder selbst entwickelte Befragungen (Pettersson et al. 2018), wie bspw. dem User Experience Questionnaire (UEQ). Solche Methoden eignen sich zur Erfassung kognitiver Einstellungen, liefern bei Emotionen jedoch verzerrte Ergebnisse, z.B. aufgrund von Interviewer-Einfluss oder sozial erwünschtem Antwortverhalten (Hahn/Bartl 2019).

Lange war Emotionsmessung mit teuren und komplizierten Apparaturen verbunden. Die rasanten Entwicklungen, u.a. in den Bereichen maschinelles Lernen, Gesichtserkennung, Sensorqualität oder Datenverarbeitung, versprechen jedoch einen radikalen Wandel in der Aufmerksamkeits- und Emotionsforschung. Die Technologie des Affective Computing erfasst und analysiert Nutzerdaten zu Aufmerksamkeit und Emotionen zuverlässig, valide und skalierbar, mit reduzierten Kosten und mit hoher Geschwindigkeit. Affective Computing bezieht sich dabei auf die Entwicklung von IT-Systemen und Geräten zur Erfassung, Interpretation, Verarbeitung und Simulation menschlicher Emotionen. Dieses interdisziplinäre Forschungsfeld integriert Sensoren, Algorithmen und die Expertise von Experten aus Informatik, Medizin, Marketing, Psychologie und Kognitionswissenschaften, um psychophysiologische Signale und Aktionen menschlicher Nutzer (z.B. Mimik, Stimmfrequenz, Herzfrequenz, Gestik) zu erfassen, zu bewerten, zu klassifizieren und zu interpretieren (Picard 1997).

Auf der Grundlage psychophysiologischer Daten zielt Affective Computing darauf ab, Stimmungen und Emotionen der Konsumenten zu erkennen (Hahn/Maier 2018). Beispielsweise können Wearables Herzfrequenz und Hautwiderstandsdaten aufzeichnen, um Stimmungen zu berechnen. Facial Coding kann stärkere emotionale Zustände skalierbar und ohne Beeinflussung der Person aufzeichnen. Facial Coding ermöglicht es zudem, emotionale Zustände zu registrieren, ohne die Benutzer direkt zu befragen und minimiert somit bewusste oder unbewusste Verzerrungen. Solche Videoanalysen können meist die sechs Grundemotionen erkennen: Freude, Überraschung, Traurigkeit, Angst, Ekel und Wut.

Zur Demonstration, wie sich User-Emotionen mittels Affective Computing messen lassen und Erkenntnisse für ein empathisches UX-Design erzielbar sind, wurden im Rahmen dieses Beitrages experimentelle Studien durchgeführt. Dafür wurden Nutzer gebeten, eine vordefinierte Hotelbuchung über einen textbasierten Chatbot vorzunehmen.

Während des gesamten Versuchszeitraums wurden Nutzeraktivitäten unterschiedlich gemessen; z.B. durch Mausbewegungen auf dem Bildschirm per Video, Klicks per Log-Dateien und Nutzeremotionen durch Facial Coding per Videos, die das Gesicht des Nutzers aufzeichneten. Zur Auswertung der Gesichtsemotionen wurde ein Algorithmus des Münchner Tech-Startups Deeply verwendet, der auf der SHORE®-Bibliothek des Fraunhofer IIS (Fraunhofer IIS 2019) basiert. Zusätzlich wurden kognitive Konstrukte, wie “Ad Liking” oder “Perceived Usability”, durch Ex-ante- und Ex-post-Befragungen auf der Grundlage etablierter Marketingforschungsskalen gemessen, um zusätzlich Fragebogendaten zu erheben.

Die Ergebnisse deuten darauf hin, dass die objektive Messung diskreter Emotionen, wie z.B. “Freude beim Werbespot”, tendenziell valider ist als die subjektive, auf der Umfrage basierende, selbstberichtete Emotionsmessung. Dieses Ergebnis verdeutlicht, dass die Nutzer nicht in der Lage oder nicht bereit sind, ihre eigenen Emotionen akkurat wiederzugeben, während die objektive Messung validere Daten erzeugt. Dies zeigt, dass der Einsatz von Affective Computing die Messung von Nutzeremotionen besser, in Echtzeit und ohne zusätzlichen Zeitaufwand für den Nutzer ermöglicht.

Das Experiment verdeutlicht, dass die Nutzer ihre eigenen Stimmungen und Emotionen verzerrt berichten und dass Fehlinterpretationen auf Basis solcher Daten zu nicht optimalen UX-Designs führen können. Im Experiment zeigt sich, dass die Nutzer zwar die Usability einigermaßen korrekt beurteilen konnten, ihre eigenen Gefühle und Stimmungen konnten sie aber nur teilweise richtig einordnen. Diese hatten aber einen maßgeblichen Einfluss auf die objektive und subjektiv wahrgenommene User Experience. Die objektive Messung auf der Grundlage des tatsächlichen Benutzerverhaltens lieferte bessere Ergebnisse. Dies entspricht nicht zuletzt der digitalen Praxis, Logfile-Analysen anstelle von Selbstberichten der Nutzer zu verwenden.

3. Aufmerksamkeit mit Eye Tracking messen

Eye-Tracking-Messungen analysieren die visuelle Aufmerksamkeit von Konsumenten. Die Aufmerksamkeit eines Konsumenten zeigt, welche Reize seiner Umgebung er überhaupt wahrnimmt. Unsere Aufmerksamkeitskapazitäten sind selektiv und begrenzt. Die steigende Anzahl von Kommunikationsformen und -kanälen konkurriert um diese Aufmerksamkeitskapazitäten und macht sie zu einem entscheidenden KPI des (digitalen) Marketings.

In der Vergangenheit war die Eye-Tracking-Technologie zunächst auf teure Laborumgebungen mit komplexen Hard- und Softwareeinstellungen beschränkt. Heute haben führende Anbieter, wie SMI und Tobii, qualitativ hochwertige Lösungen für den stationären und mobilen Einsatz etabliert, die zahlreiche Funktionen und unterstützende Werkzeuge für die Datenanalyse bereitstellen. Weitere Anbieter haben inzwischen Basislösungen entwickelt, mit denen sich Fixationen verfolgen und einfache, standardisierte Auswertungen durchführen lassen.

Neben der qualitativen Beschreibung von Blickbewegungen über Heatmaps, werden zur Performance-Messung zunehmend auch quantitative Leistungsindikatoren eingesetzt (Djambashi et. al. 2011). Time-to-first-fixation (TTFF) gibt die Dauer vom ersten Erscheinen des visuellen Reizes bis zur ersten Wahrnehmung an. Die Fixationsdauer misst die Länge der visuellen Betrachtung (Geise 2011). Fixationszählungen überprüfen die Anzahl wiederkehrender Besuche zu einem Stimulus. Bei digitalen Produkten misst Time-to-Click (TTC) zusätzlich die Zeit, bis ein Benutzer nach der Betrachtung eine angestrebte Call-to-action-Handlung ausführt.

Für eine empirische Studie zur Messung der Aufmerksamkeitsleistung von Landing Pages wurde die visuelle Betrachtung und Folgehandlung auf prämierten Webseiten einer Produktkategorie mit Standardseiten von unmittelbaren Wettbewerbern verglichen. In einem Laborumfeld mit Tobii TX60 Messgeräten sollten 100 Nutzer vordefinierte Angebotsinformationen auf den jeweiligen Webseiten finden. Wie erwartet, erreichten die preisgekrönten Landing Pages bessere Aufmerksamkeits- (TTFF) und Folgehandlungswerte (TTC) als ihre Konkurrenten: Verglichen mit den nicht-preisgekrönten Landing Pages, registrierten die Probanden das jeweils ausgelobte Angebot etwas schneller (1,9 Sek. vs. 2,1 Sek.). Dies lässt sich auf visuelle Anziehungseffekte von auf den preisgekrönten Landing Pages eingesetzten Farben, Kontrasten und Formen zurückführen. Zudem unterschieden sich die TTC-Performance-Werte der preisgekrönten Landing Pages (6,9 Sek.) signifikant von denen regulärer Websites (9,9 Sek.).

Nach Abschluss der vergleichenden Eye-Tracking-Messungen wurden die Nutzer anhand einer Likert-Skala gefragt, welche der konkurrierenden Landing Pages ihnen am besten gefallen hat. Überraschenderweise ergaben diese über den klassischen Fragebogen erhobenen Messungen keine signifikanten Unterschiede in der Einschätzung. Die prämierten Landing Pages und die der jeweiligen Wettbewerber erhielten nahezu identische Bewertungen. Dieses Ergebnis macht deutlich, dass der Mehrwert apparativ erzielter Eye-Tracking-Messungen im Vergleich zu Konsumentenabfragen in der Exaktheit liegt und besser für eine Prognose verwendbar ist als Selbstauskünfte von Nutzern.

4. Kombination von Affective Computing und Eye Tracking

Die obigen Studien zeigen, dass die Emotions- und Eye-Tracking-Daten im Vergleich zu klassischen Befragungen validere Ergebnisse liefern können. Eine Kombination beider Methoden könnte zu noch interessanteren Erkenntnissen führen: Eye Tracking bereichert die Emotionsanalyse, weil es ermöglicht, klar zu erkennen, welcher visuelle Stimulus eine bestimmte Emotion oder Stimmungsreaktion ausgelöst hat. Zeigen Anwender in einer Studie ähnliche emotionale Reaktionen, lassen sich bestimmte Emotionsspitzen leicht auf den sequenziellen Fluss der Stimuli zurückführen. Im Falle von Nutzergruppen, die unterschiedliche emotionale Reaktionen zeigen, erlaubt ein ergänzendes Eye Tracking den Einblick, ob diese Gruppen ihre Aufmerksamkeit im Zeitverlauf auf verschiedene Stimuli richten.

Die Emotionsanalyse bereichert gleichzeitig die Aufmerksamkeitserfassung und gibt Einblicke in eine tiefergehende Schicht von aufmerksamkeitsinduzierenden Stimuli. Die Fixierung auf ein visuelles Element bedeutet nicht notwendigerweise, dass der Betrachter das dargestellte visuelle Element positiv bewertet. Vielmehr kann der Inhalt verwirrend sein oder mit der Erinnerung an frühere – auch negative – Erfahrungen in Verbindung gebracht werden.

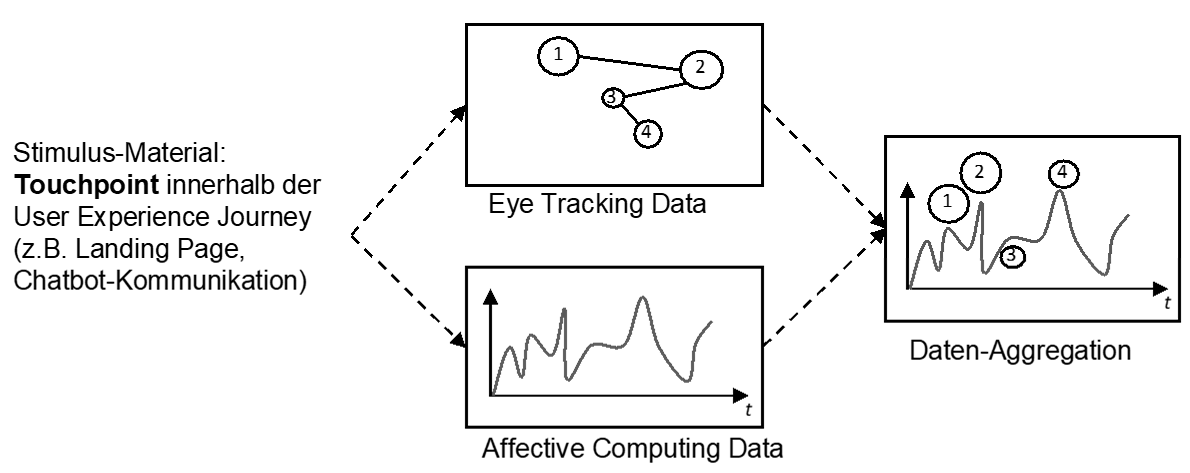

Für die Durchführung einer gemeinsamen Messung von Aufmerksamkeit und Emotionen bietet sich die Kombination aus stationären Eye-Trackern und Facial Coding an. Bei vielen Eye-Tracking-Systemen wird das Gesicht des beobachteten Probanden über eine zugeschaltete Webcam automatisch mit aufgezeichnet. Für die Möglichkeit, dieses anschließend analysieren zu können, muss die explizite Zustimmung des Probanden schriftlich vorliegen und zudem bei der Aufzeichnung auf einen neutralen Hintergrund des aufgenommenen Gesichts geachtet werden. Über einen Zeitstempel der beiden Aufnahmen lassen sich die Ergebnisse der visuellen Fixationsverläufe und der emotionalen Kurvendiagramme zueinander in Beziehung setzen (vgl. Abbildung 1). Dabei müssen Zeitverzögerungen bei der emotionalen Reaktion auf visuelle Reize ermittelt und berücksichtigt werden (Mariooryard/Busso 2015).

Für die Auswertung der erhobenen Ergebnisse bieten sich zwei Vorgehensweisen an: Die Outside-In- und die Inside-Out-Analyse. Bei einer Outside-In-Analyse werden zunächst die Eye-Tracking-Daten analysiert und bei Besonderheiten in den etablierten Performance-Werten (TTFF, TTC, etc.) die Ausschläge der Stimmung oder diskrete Emotionen hinzugezogen. Diese Herangehensweise entschlüsselt die empathische Interaktion von Nutzern mit der Bildschirmoberfläche über deren visuellen Eindruck und postuliert, dass die Schönheit im Auge des Betrachters liegt.

Eine Inside-Out-Analyse konzentriert sich hingegen auf die emotionalen Spannungskurven der Nutzer. Beim Überschreiten von positiven Schwellenwerten kann über das Hinzuziehen der Fixationsbereiche der Auslöser für die jeweilige Stimmung analysiert werden. Die Herausforderung bei diesem Ansatz liegt dabei in den – im Vergleich zum Eye Tracking – noch nicht ausreichend etablierten und vergleichbaren Kennzahlen-Standards für emotionale UX.

Über wiederholte, kombinierte Aufmerksamkeits- und Emotionsmessungen werden sich mit der Zeit Muster über das Zusammenspiel der jeweiligen KPI-Werte erkennen lassen. Im nächsten Schritt gilt es, über KI-gestützte Systeme die identifizierten Muster zu klassifizieren und damit die Enkodierung digitaler Empathie voranzubringen.

Literatur

Djambashi, S./Siegel, M./Skorinko, J./Tullis, T. (2011): Online Viewing and Aesthetic Preferences of Generation Y and the Baby Boom Generation: Testing User Web Site Experiences Through Eye Tracking, in: International Journal of Electronic Commerce, 15(4), pp. 121-157.

Fraunhofer IIS (2019): Face Detection Software SHORE®: Fast, Reliable and Real-time Capable, https://www.iis.fraunhofer.de/en/ff/sse/ils/tech/shore-facedetection.html, retrieved October 10, 2019.

Geise, S. (2011): Eyetracking in der Kommunikations- und Medienwissenschaft. Theorie, Methode und kritische Reflexion, in: SCM Studies in Communication Media, Nr. 2/2011, S. 149-126.

Hahn, A./Bartl, M. (2019): Wie Affective Computing kostengünstig, schnell, zuverlässig, valide und skalierbar Nutzer-Emotionen messen kann, um empathische Marktforschung anzureichern, Paper präsentiert zum 54. Kongress der Deutschen Marktforschung am 20. – 21.05.2019 in Hamburg.

Hahn, A./Maier, M. (2018): Affective Computing: Künstliche Potenziale Intelligenz für empathisches digitales Marketing, Marketing Review St. Gallen, 4, pp. 52-65.

Mariooryad, S./Busso, C. (2015): Correcting Time-Continuous Emotional Labels by Modeling the Reaction Lag of Evaluators, IEEE Transactions on Affective Computing, Vol. 6/ Issue: 2, p. 97-108

Pettersson, I./Lachner, F./Frison, A.-K./Riener, A./Butz, A. (2018): A Bermuda Triangle?, in: Proceedings of the 2018 CHI Conference on Human Factors in Computing Systems, ACM.

Picard, R. (1997): Affective Computing, Cambridge MIT Press.

Um einen Kommentar zu hinterlassen müssen sie Autor sein, oder mit Ihrem LinkedIn Account eingeloggt sein.