Künstliche Intelligenz verspricht Innovationen, die den Menschen in seiner Arbeit und im Alltag hilfreich unterstützen könnten. Inwieweit diese tatsächlich realisiert werden, hängt maßgeblich davon ab, ob die Menschen Vertrauen in die Technologie setzen. Welche Herausforderungen ergeben sich für die verantwortungsbewusste Entwicklung und Anwendung von KI-Systemen? Nach welchen Kriterien sollen diese umgesetzt werden? Und was können Unternehmen tun, um KI diskriminierungsfrei anzuwenden? Antworten darauf liefert ein Leitfaden der Plattform Lernende Systeme.

Neue Technologien werden immer dann Gegenstand der gesellschaftlichen und wissenschaftlichen Ethik-Diskussion, wenn sie zu Verunsicherungen führen und neue moralische Probleme aufwerfen. Das ist etwa der Fall, wenn Künstliche Intelligenz zu Diskriminierungen oder ungewissen, riskanten Handlungsfolgen führt, z. B. bei ihrem Einsatz in Autos oder in kritischen Infrastrukturen wie dem Energiesektor.

Die KI-Entwicklung soll der Gesellschaft dienen und nicht dazu führen, dass neue technische oder wirtschaftliche Zwänge entstehen, die ethische Normen des Zusammenlebens verletzen oder positive Entwicklungen beschränken. Das ist ja eigentlich damit gemeint, wenn in vielen politischen Dokumenten und Reden von „KI für den Menschen“ die Rede ist. Generell ist es wichtig, die Handlungsroutinen und Handlungsempfehlungen, die durch KI-Systeme vorgegeben werden, nicht als alternativlos bzw. als „Sachzwang“ anzuerkennen. Wie in andere technische Produkte auch, sind in KI bestimmte, veränderbare Zwecke und Präferenzen eingeschrieben, die bestimmten Gruppen und Individuen nutzen, anderen aber schaden können.

Technische Innovationen schaffen häufig neue Handlungsräume, für die bekannte ethische Verhaltensformen keine Antwort geben. Sie müssen also neu diskutiert, reflektiert und ausgehandelt werden. Um diesen Prozess gesellschaftlich für KI voran zu bringen, müssen ethische Leitlinien erstellt und vor allem auf ihre praktische Umsetzbarkeit geprüft werden.

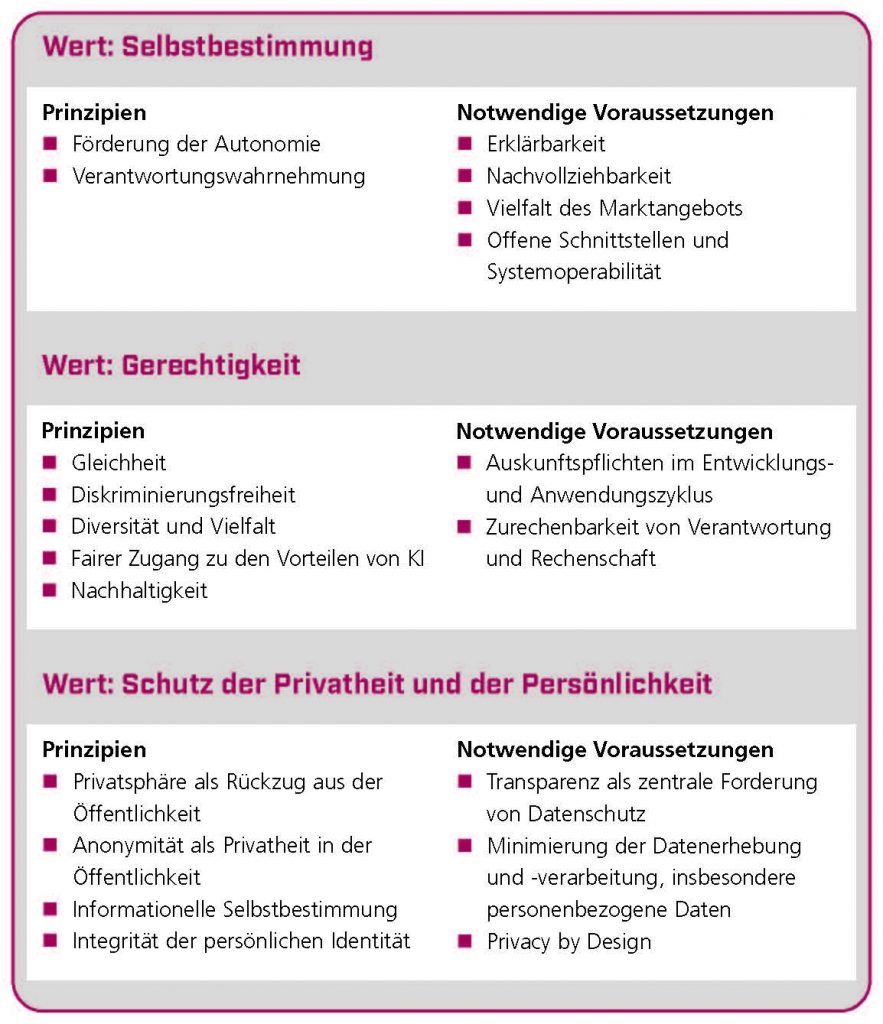

Selbstbestimmung, Gerechtigkeit und Privatheit als Grundwerte

Die Entwicklung des Leitfadens „Ethik-Briefing für eine verantwortungsvolle Entwicklung und Anwendung von KI“ der Plattform Lernende Systeme war getrieben von der Überzeugung, dass die erarbeiteten Werte, Kriterien und Handlungsoptionen nicht losgelöst von ihrer praktischen Anwendung betrachtet werden können. Deshalb steht in den Briefings eine übersichtliche Orientierung an zentralen Leitwerten der KI-Entwicklung im Vordergrund: Selbstbestimmung, Gerechtigkeit und Schutz der Privatheit. Aus diesen Werten werden Konkretisierungen abgeleitet und für die praktische Umsetzung ausgearbeitet.

Was bedeutet z. B. Selbstbestimmung im Kontext von KI-Anwendungen? Es ist häufig davon die Rede, dass KI die Autonomie des Menschen beschränken oder sogar selbst autonome Entscheidungen treffen könnte, die dem Menschen schaden. Trotzdem machen ja gerade die Fähigkeiten von KI-Systemen zum selbstständigen Lernen und ihre Anpassungsfähigkeit ihren Reiz aus. KI-Systeme sollen den Menschen entlasten; damit dies aber nicht auf Kosten, sondern zur Unterstützung der menschlichen Selbstbestimmung passiert, sind bestimmte Rahmenbedingungen und Regeln entscheidend.

Auf individueller Ebene gehören dazu ein verständliches Interaktionsdesign, Transparenz oder ein „Aus-Knopf“ zur Unterbrechung einer KI-Anwendung – und natürlich der Vorbehalt der menschlichen Letztentscheidung. Auch auf infrastruktureller Ebene gibt es viele Ansätze um Selbstbestimmung umzusetzen. Hier geht es vor allem um die Sicherung von Vielfalt in Hinsicht auf Dienste und Anbieter. Gerade im boomenden Bereich der Plattformökonomie – also einer Marktstruktur, in der digitale Plattformen Anbieter und Konsumenten über einen vorstrukturierten Handels- und Kommunikationsplatz zusammenbringen – herrschen monopolartige Strukturen vor. Da die Programmierung von leistungsstarken KI-Systemen ressourcenaufwendig und kostenintensiv ist, ist zu erwarten, dass von großen Anbietern eingesetzte, erfolgreiche KI-Systeme diese Macht weiter vergrößern. Um die Vielfalt auch im Bereich der digitalen Ökonomie zu gewährleisten, Wahlmöglichkeiten zu erhalten und damit Selbstbestimmung zu fördern, sollten insbesondere große Anbieter ihre Systeme interoperabel konzipieren und offene Schnittstellen in ihre Systeme integrieren.

Ethics by, in and for Design

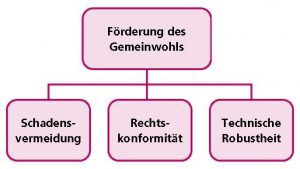

Wie das Beispiel zeigt, geht es nicht nur um das richtige oder falsche Handeln von Individuen, sondern ebenso um die Schaffung von Strukturen, die ethisches Handeln ermöglichen und unterstützen. Wert- und Gemeinwohlorientierung von KI spiegeln sich deshalb auch in dem Aufbau von technischen Rahmenbedingungen wider.

Dementsprechend beschäftigen sich zahlreiche Ansätze aus Wissenschaft, Recht und Politik mit einem „ethics by, in and for design“-Ansatz. Ethische Prinzipien sollen demnach von Anfang an in die Entwicklung von KI-Systemen einbezogen werden.[1]

Ein zentraler Akteur für die Umsetzung von ethischen Designentscheidungen sind Unternehmen und Start Ups. Die aus ethischer Sicht relevanten Aspekte einer Technikentwicklung beginnen jedoch nicht erst im Rahmen der Arbeit der entwickelnden Ingenieurinnen und Ingenieure. Bereits die strategische Ausrichtung eines Unternehmens und die hinter der Technologieentwicklung stehenden Konzepte zur Kommerzialisierung sind wesentliche Elemente für ein gelingendes ethisches Gesamtkonzept.

Ein wichtiges Ziel von anwendungsbezogenen Ethikkodizes und auch spezifisch des „Ethik-Briefings“ der Plattform Lernende Systeme ist demnach die Rückkopplung der Werte und Handlungsoptionen an die unternehmerische Praxis. Im Zentrum steht dabei die Frage, ob die theoretischen Werte in der Praxis realisierbar sind. Bereits heute legen viele Unternehmen Wert auf einen ethisch basierten Entwicklungs- und Anwendungsprozess von KI-Systemen. Dabei spielen verschiedene Faktoren eine Rolle: die Unternehmenskultur und -ethik, der Absatzmarkt für „gute“ Produkte und auch die Erfüllung rechtlicher Standards.

Wunsch nach verbindlichen Regeln

Eine gängige Befürchtung lautet: Die Einhaltung von ethischen Werten und Prinzipien, die nicht vorrangig der Logik des Marktes folgen, führen dazu, im freien Wettbewerb Nachteile zu erleiden und damit wirtschaftlich abgehängt zu werden. Diese Sorge teilen die im Ethik-Briefing befragten Unternehmen jedoch nicht und auch im globalen Kontext, wird der Wunsch nach verbindlichen Regeln für alle immer deutlicher.

Ethische Prinzipien und Werte sind der Ausgangspunkt für vertrauenswürdige KI. Sie bilden damit die Grundlage für eine mögliche Regulierung und Zertifizierung von KI-Systemen, für die es aktuell zahlreiche Bestrebungen gibt.[2] Für eine Zertifizierung spielt vor allem die Frage nach der Kritikalität von KI-Systemen eine bedeutende Rolle. Nicht für jede KI-Anwendung sind ethische Standards gleich dringlich. Allgemein lässt sich die Faustformel aufstellen: Je höher die Risiken durch den Einsatz eines Systems sind, desto mehr Gewicht soll bereits im Entwicklungsprozess die Einhaltung ethischer Prinzipien haben.

Prinzipien für die verantwortungsbewusste KI-Entwicklung

Ethische Anforderungen an KI-Systeme

Quellen und Referenzen

[0] Whitepaper „Ethik-Briefing“, https://www.plattform-lernende-systeme.de/files/Downloads/Publikationen/AG3_Whitepaper_EB_200831.pdf

[1] Siehe z. B. High Level Expert Group on Artificial Intelligence der EU-Kommission (HLEG), https://ec.europa.eu/digital-single-market/en/high-level-expert-group-artificial-intelligence; OECD Council Recommendation on Artificial Intelligence, https://legalinstruments.oecd.org/en/instruments/OECD-LEGAL-0449; AI Ethics Impact Group, https://www.bertelsmann-stiftung.de/fileadmin/files/BSt/Publikationen/GrauePublikationen/WKIO_2020_final.pdf

[2] Siehe die KI-Normungsroadmap, https://www.din.de/de/forschung-und-innovation/themen/kuenstliche-intelligenz/normungsroadmap-ki

Um einen Kommentar zu hinterlassen müssen sie Autor sein, oder mit Ihrem LinkedIn Account eingeloggt sein.