In Wissenschaftskreisen wird Quantencomputing schon seit mehr als zwei Jahrzehnten als die Technologie der Zukunft beschworen. Mittlerweile setzt auch die Industrie auf die Revolutionierung der IT durch Qubits. Gerade die Finanzwirtschaft mit immer komplexer werdenden Berechnungen und Prognosen könnte von der erheblich kürzen Berechnungszeit profitieren, die Quantencomputer versprechen. Erstaunlich dabei: Bei einigen Technologien ergeben sich zusätzlich deutliche Energieeinsparungen. Dieser Beitrag beleuchtet das Thema Quantencomputing aus der Perspektive der Finanzwirtschaft, zeigt mögliche Einsatzgebiete und Rechnerarchitekturen und erläutert, auf was es beim Aufbau der Lösungen in Rechenzentren zu achten gilt bzw. wo die Vorteile der Technologie liegen.

Was ist Quantencomputing?

Quantencomputing basiert auf den Gesetzen der Quantenmechanik, die erstmals zu Beginn des 20. Jahrhunderts entdeckt wurden und die die Welt in den mikroskopischen Dimensionen von Atomen und Molekülen beschreiben. Praktisch angewendet werden die quantenmechanischen Effekte heutzutage beispielsweise in Magnetresonanztomographen oder LEDs (light emitting diode). Das Quantencomputing selbst basiert auf individuellen quantenmechanischen Phänomenen. Betrachtet man das Quantencomputing im Vergleich zu der klassischen Digitaltechnik, besteht der größte Unterschied im kleinsten Baustein: dem Bit im Vergleich zum Qubit. Während ein Bit genau einen seiner zwei Basiszustände annimmt – Null oder Eins – kann ein Qubit auch eine Überlagerung der Basiszustände annehmen. Diese bezeichnet man als Superposition. Die Qubits sind zudem in der Lage, sich gemäß den Gesetzen der Quantenmechanik zu verschränken. Diese einzigartige Eigenschaft des Quantencomputing wird genutzt, um komplexe Probleme durch verschränkte Zustände so abzubilden, dass Information, einfach gesagt, parallel verarbeitet werden kann. Gelingt dies, lassen sich mit Quantenalgorithmen Rechenzeit einsparen und Antworten auf Probleme finden, die sich mit aktuellen Technologien nicht lösen lassen.

Worauf basiert Quantencomputing?

Quantencomputing erfordert einerseits die entsprechende Quanten-Hardware, andererseits spezielle Algorithmen, die individuell entwickelt werden müssen. Nur zehn Jahre nachdem die ersten Ideen zum Quantencomputing ausgetauscht wurden, veröffentlichte Peter Shor 1994 für die AT&T Bell Labs den ersten überlegenen Algorithmus zur Faktorisierung von Integerzahlen. Was auf den ersten Blick nach einer rein wissenschaftlichen Fragestellung aussieht, erweist sich bei näherer Betrachtung als Problem mit praktischer Relevanz: Die Faktorisierung bzw. die Berechnung diskreter Logarithmen bildet die Basis moderner Kryptographie. Allerdings erfordern die Algorithmen fehlerfreie bzw fehler-korrigierte Qubits. Derart „perfekte“ Qubits kann man realisieren, indem man mehrere Qubits mit geringen Fehlern zu sogenannten logischen Qubits zusammenfasst. Mit speziellen Algorithmen kann man dann Fehler in einzelnen Qubits detektieren, und auf Ebene des logischen Qubits Quantenspeicher mit geringerer Fehlerrate schaffen. Als Herausforderung erweist sich jedoch, dass sich damit die Rechenzeit und die erforderliche Anzahl von Qubits erhöhen. Aus diesem Grund setzen Entwickler aktuell verstärkt auf Optimierungs-Algorithmen, die auch auf nicht-fehlerkorrigierten Qubits arbeiten können. Diese Algorithmen nutzen hardwareseitig hybride Computing-Architekturen bestehend aus klassischen IT-Systemen und Quantenrechnern. Quantencomputer werden eingesetzt, um die eigentlichen, sehr komplexen Aufgaben zu lösen, während klassische Computersysteme das Feintuning der Quantenalgorithmen übernehmen. In diesem Setup lassen sich bereits heute Quantenalgorithmen entwickeln und testen, die perspektivisch für Business-Anwendungen genutzt und einfach an die zukünftige Quantencomputer angepasst werden können.

Welche Finanz-Anwendungen lassen sich optimieren?

Die Herausforderungen des Quantencomputing zeigen sich bei einer praktischen Umsetzung: Welche Anwendungsprobleme lassen sich sinnvoll mit Quantencomputern lösen? Was muss bei der Entwicklung des Algorithmus beachtet werden? Welche Hardware ist verfügbar? Um Anwendern diese Fragen beantworten und pragmatische Lösungen an die Hand geben zu können, schlossen sich verschiedene Anbieter (AQT, JoS QUANTUM, SVA System Vertrieb Alexander und NTT GDC) zu einem Pilotprojekt zusammen und erarbeiteten gemeinsam im Technology Experience Lab von NTT Global Data Centers in Frankfurt ein Konzept für Anwendungen des Quantencomputing. Da die Technologie gerade in Hinblick auf komplexe finanzmathematische Berechnungen deutliche Vorteile verspricht, wählte man exemplarisch Finanz-Anwendungen als Ausgangspunkt:

Bei der Optimierung eines Investment Portfolios gilt es eine Vielzahl von Parametern zu berücksichtigen. Eine Investitionssumme soll auf verschiedene Assets so verteilt werden, dass ein hoher Return on Investment erzielt und gleichzeitig das Risiko minimiert wird. Sollen dabei jedoch diskrete Stückzahlen berücksichtigt werden (was näher an der Realität ist), liefern klassische Algorithmen trotz langer Laufzeiten meist keine optimalen Ergebnisse. Gilt es nun auch noch stochastische Werte, wie z.B. Zinsentwicklungen, wirtschaftliche Faktoren und Unsicherheiten bei der erwarteten Rendite als Eingangsparameter zu berücksichtigen, wird aus dem gemischt-ganzzahligen ein stochastisches Optimierungsproblem. In diesem Fall können Quantencomputer die Unsicherheiten der Eingangsparamater innerhalb der Optimierung berücksichtigen, um damit die kombinatorische Optimierung effizienter zu lösen und bessere Ergebnisse in kürzerer Zeit zu erzielen.

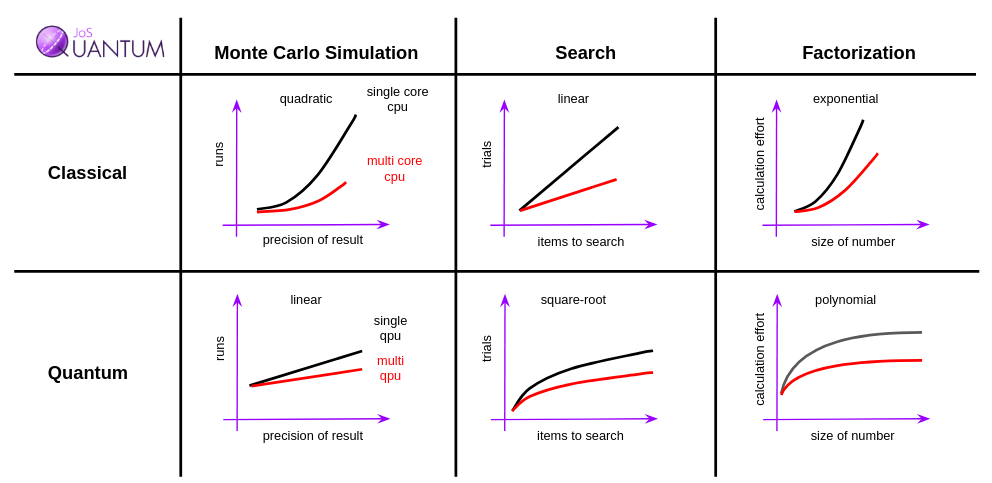

Das gleiche gilt auch für hochdimensionale Monte-Carlo-Simulationen, wie sie beispielsweise für die Evaluation von Finanzinstrumenten genutzt werden. Dabei müssen Millionen unterschiedlicher Szenarien entwickelt und deren Ergebnisse kalkuliert werden. Daraus ergibt sich eine Verteilung, aus der Risikokennzahlen und Erwartungswerte bestimmt werden. Mittels Quantenalgorithmen kann die Simulation der Szenarien und der damit verbundenen Risiken deutlich beschleunigt bzw. durch die Berücksichtigung einer größeren Anzahl an Möglichkeiten genauer kalkuliert werden. Diese Arten der Simulationen lassen sich nicht nur für die Preisberechnung von Derivaten, sondern für alle Arten von Risiken – beispielsweise von systemischen und Kreditrisiken – verwenden. Generell gibt es eine große Zahl an Anwendungsbereichen für Monte-Carlo Simulationen, auf die zurückgegriffen wird, falls eine analytische Lösung nicht einfach möglich ist. Für alle diese stochastischen Prozesse lassen sich zukünftig Quantencomputer einsetzen.

Wie lassen sich diese Anwendungen mit Quantencomputern umsetzen?

Softwareseitig erfordert die Entwicklung von Algorithmen für das Quantencomputing – ganz gleich ob für Finanzanwendungen oder andere Applikationen – tiefgreifendes Know-how, das bislang in den wenigsten Unternehmen vorhanden ist. Gemeinsam mit externen Experten lässt sich dieses aber mittelfristig aufbauen, und dies sehr kosteneffizient. Stellt sich nun die Frage nach der geeigneten Hardware für das Quantencomputing. Hier gibt es unterschiedliche Ansätze: Schon heute sind cloudbasierte Lösungen verfügbar, die es erlauben, lokale Software-Development-Kits auf einem Laptop mit einem Quantenrechner in der Cloud zu verbinden. Für Anwendungen der Banken- und Versicherungsbranche ist deren Nutzung allerdings kritisch, da hohe sicherheitstechnische Auflagen erfüllt werden müssen. In der Regel benötigen die Algorithmen als Eingangswerte sensible Daten, die es – wie auch die Ergebnisse der Berechnungen – vor unerlaubten Zugriffen zu schützen gilt. Zudem muss auch die Frage nach dem geistigen Eigentum gestellt werden; in einer öffentlichen Cloud für Quantencomputing kann dies in der Regel nur schwierig ausreichend geschützt werden.

Im Rahmen der nachfolgenden Abschnitte beleuchten wir aus diesem Grund Ionenfallen-basierte Quantencomputer. Hier entstehen die Qubits, indem die Ionen in einer mikrostrukturierten Falle gefangen und mit hoch-fokussierten Laserstrahlen kontrolliert werden. Diese Technologie bietet mehrere Vorteile: Sie arbeitet einerseits sehr zuverlässig und lässt sich gleichzeitig sehr gut standardisieren, lokal installieren und auch aus der Ferne warten. Mehr noch: Sie arbeitet nachhaltig und autark.

Warum ist Quantencomputing mit Ionenfallen-Technologie nachhaltig?

Quantencomputer basierend auf der Ionenfallen-Technologie sind schon heute verfügbar und lassen sich in einem klassischen 19“ Rack im Rechenzentrum einbauen. Ein gesamtes System benötigt nur zwei komplette Serverschränke und damit weniger als 4 Quadratmeter Rechenzentrumsfläche. Erstaunlich ist der Energieverbrauch. Er liegt bei dem beschriebenen System bei weniger als 3 kW und steigt auch bei höherer Rechenleistung nicht signifikant an. Damit wird der Dauerbetrieb nicht nur günstiger in Hinblick auf die verbrauchte Leistung für die Recheneinheit, es entsteht insgesamt weniger Abwärme. Auch die Betriebstemperatur erweist sich als vorteilhaft: Während supraleitende Qubits Elektronik erfordern, die typischerweise in einem Temperaturbereich rund um den absoluten Nullpunkt bei etwa 0,1 Kelvin (also Minus 273,1 Grad Celsius) arbeitet, liegt die Betriebstemperatur der ersten Ionenfallen-Quantenrechner im Bereich der normalen Raumtemperatur zwischen 20 und 25 Grad. Energieintensive Kühlungssysteme, z.B. auf Helium-Basis, sind hier nicht erforderlich. Eine Realisierung der oben aufgezeigten Finanz-Applikationen mittels der Ionenfallen-Quantencomputer erweist sich demzufolge in mehrfacher Hinsicht als nachhaltig:

- Geringer Stromverbrauch bei hoher Rechenleistung

- Keine aufwendige Kühlung erforderlich wie bei Supraleitern

- Installation vor Ort möglich

Gibt es spezielle Anforderungen an Rechenzentren?

Unternehmen und Organisationen, die erste Anwendungen mit Quantencomputern testen möchten, können dies mit Ionenfallen-Computern einfach realisieren. Bei der Wahl, wo die Systeme betrieben werden sollen, gilt es allerdings fünf wesentliche Aspekte zu berücksichtigen:

Sicherheit – Finanzinstitute arbeiten mit sensitiven Daten und jede Entscheidung darüber, wo sich diese Daten befinden, muss sicherstellen, dass ein sehr hoher Sicherheitsstandard eingehalten wird. Die Daten müssen auf in einer hochsicheren Umgebung gespeichert und verarbeitet werden, die sowohl gegen Angriffe durch Menschenhand, aber auch vor Naturkatastrophen oder Stromausfällen geschützt ist. Damit wird die konstante Stromversorgung der Systeme gewährleistet.

Compliance – Die Mehrzahl finanztechnischer Anwendungen laufen unter regulatorischer Kontrolle. Sowohl Banken als auch Versicherungen unterliegen Regeln, wie der FISMA, PCI DSS, ISAE3402; etc.; für die Verarbeitung von Zahlungen erfordert es bei IT-Prozessen zudem, dass sie gemäß ISO 27001 BSI funktionieren.

Zugangsprüfungen – Die Daten müssen vor dem Zugriff Unbefugter geschützt werden. Strikte Zugangskontrollen sind dafür unerlässlich. Geht man davon aus, dass hier sensible Finanzdaten verwendet werden, gilt es besondere Vorsicht walten zu lassen.

Stabile Umgebung – Um den kontrollierten und sicheren Betrieb der Quantenrechner zu gewährleisten, sollten die Systeme auf einem Untergrund gestellt werden, der Vibrationen minimiert und andere Einflüsse aus der Umgebung abschirmt. Weiterhin ist eine konstante Temperatur zwischen 20 – 25 Grad Celsius essenziell.

Konnektivität – Noch gibt es nur wenige spezielle Quantenübertragungen (z.B. Quantum Internet) über größere Distanzen. Vielmehr werden die Ergebnisse direkt in klassische IT verständliche Bits umgewandelt und kommuniziert. Eine schnelle und zuverlässige Netzwerkanbindung sowie – abhängig von der jeweiligen Applikation – eine direkte Anbindung an Internetknoten und Cloud-Services werden empfohlen.

Berücksichtigt man diese fünf wesentlichen Aspekte, bietet sich gerade für eine so neue Technologie wie das Quantencomputing der sichere Betrieb in einem professionell betriebenen Colocation-Rechenzentrum an.

Wie lässt sich Quantencomputing risikolos testen?

Die Chancen des Quantencomputing zu erkennen ist das eine, sie konkret zu ergreifen das andere. Gerade für Finanzinstitute stellt sich auch hier die Frage nach der Sicherheit: Keinesfalls sollen Produktivsysteme durch Testszenarien gefährdet werden. Doch wer die Technologie langfristig nutzen möchte, sollte schon jetzt Erfahrungen sammeln. NTT Global Data Centers bietet aus diesem Grund in mehreren Rechenzentren sogenannte Technology Experience Labs an, in denen mehr als 100 unterschiedliche Soft- und Hardware-Partner eigene Systeme implementieren und anderen Unternehmen für Tests und Innovationsprojekte zur Verfügung stellen. In diesem Beispiel ermöglicht es die Implementation des Testszenarios für Quantenrechner im Technology Experience Lab – direkt in einem sicheren Colocation-Rechenzentrum – Unternehmen, eigene Algorithmen für Quantencomputing zu entwickeln, die entsprechende Hardware und gleichzeitig die Nachhaltigkeit der Technologie zu testen.

Ausblick

Quantencomputer sind längst keine Science-Fiction mehr. Insbesondere die Entwicklung der Quantencomputer basierend auf der hier dargestellten Ionenfallen-Technologie bietet greifbare Chance für viele Unternehmen, darunter auch Finanzinstitute und Versicherungen. Die Hardware lässt sich individuell und autark installieren und betreiben. Wie klassische IT-Systeme ist ein stabiles und sicheres Umfeld erforderlich. Belohnt werden die Unternehmen mit nachhaltigen Rechensystemen, die sich einfach in sicheren Colocation Rechenzentren betreiben lassen, die zukünftigen Anforderungen in Hinblick auf Rechenleistung erfüllen und gleichzeitig den Stromverbrauch reduzieren.

Um einen Kommentar zu hinterlassen müssen sie Autor sein, oder mit Ihrem LinkedIn Account eingeloggt sein.